- Willkommen im Forum „BLOG“.

BLOG

powered by JoLichter.de

Neuigkeiten:

Privates MODX und LINUX BLOG, User Registrierung ist deaktiviert! Fragen oder Tipps? Bitte per Matrix: @jo42:freiburg.social

Neueste Beiträge

#1

LINUX / Antw:Passwortmanager KeePassXC...

Letzter Beitrag von Jo - 2025-01-08 | 21:57:06Ältere YubiKeys haben eine nicht behebbare Sicherheitslücke – aber sie ist schwer auszunutzen

Im Jahr 2024 wurde eine Sicherheitslücke in bestimmten YubiKey-Modellen entdeckt. Diese Schwachstelle betrifft die ECDSA-Implementierung in der kryptografischen Bibliothek von Infineon, die in YubiKey 5 Series und YubiHSM 2 mit Firmware-Versionen vor 5.7.0 bzw. 2.4.0 verwendet wird.

Um diese Schwachstelle auszunutzen, muss der Angreifer physischen Zugriff auf den betroffenen YubiKey haben. Der Angriff basiert auf sogenannten Seitenkanaltechniken, bei denen Informationen aus der Hardware durch physikalische Beobachtungen – wie Stromverbrauch oder elektromagnetische Emissionen – extrahiert werden. Auf diese Weise könnte es möglich sein, private Schlüssel zu rekonstruieren. Dafür ist jedoch hochgradig spezialisiertes technisches Know-how erforderlich – etwas, das ich derzeit nur großen Organisationen zutraue.

Es ist wichtig zu betonen:

Falls ein YubiKey verloren geht oder gestohlen wird, sollten betroffene Nutzer umgehend alle verknüpften Konten aktualisieren und den YubiKey aus den Sicherheitseinstellungen entfernen.

Natürlich ist es in jedem Fall ratsam, dies zu tun. Ein YubiKey – oder ähnliche Sicherheitstoken – sollte stets sicher aufbewahrt werden, ähnlich wie ein Haustürschlüssel. Allerdings bietet der YubiKey durch seine starke Authentifizierung ein höheres Maß an Sicherheit, da er – im Gegensatz zum Haustürschlüssel – nicht einfach "geknackt" werden kann. Ein Haustürschlüssel kann verloren gehen oder leicht kopiert werden – der YubiKey hingegen ist selbst bei Verlust schwer zu kompromittieren.

Ich möchte das nicht beschönigen – besonders, da Yubico meiner Meinung nach nicht angemessen auf diese Entdeckung reagiert hat. Angesichts der heutigen Komplexität ist es nahezu unvermeidlich, dass in jeder Hardware oder Software früher oder später Schwachstellen entdeckt werden. Deshalb sollte Software stets aktuell gehalten werden – ,,Never change a running system" ist heute schlicht fahrlässig. Sicherheits-Hardware, insbesondere wenn sie für sensible Daten genutzt wird, sollte alle paar Jahre ausgetauscht werden.

Gerade bei der Sicherheits-Hardware zeigt sich die Schwachstelle von Yubico – ironischerweise liegt sie in dem, was sonst die größte Stärke des YubiKeys ist. Ein Firmware-Update ist nicht möglich, da das Gerät nicht beschrieben werden kann. Dies verhindert zwar, dass Hacker eine eigene Firmware installieren, bedeutet aber auch, dass Sicherheitslücken nicht nachträglich geschlossen werden können. Es ist, als würde man die Tür zur Hölle versiegeln, aber dabei den Schlüssel zum Himmel verlieren.

Nun, wie hat Yubico darauf reagiert?

Gerade weil der YubiKey als besonders sicheres und vertrauenswürdiges Sicherheitsgerät beworben wird, ist es enttäuschend und frustrierend, dass der einzige Ausweg der Austausch gegen ein neueres Modell ist – da die Schwachstelle weder behoben noch per Patch geschlossen werden kann. Ein faires Angebot oder Rabatt für betroffene Kunden wäre hier zumindest angemessen gewesen.

Quellen:

Im Jahr 2024 wurde eine Sicherheitslücke in bestimmten YubiKey-Modellen entdeckt. Diese Schwachstelle betrifft die ECDSA-Implementierung in der kryptografischen Bibliothek von Infineon, die in YubiKey 5 Series und YubiHSM 2 mit Firmware-Versionen vor 5.7.0 bzw. 2.4.0 verwendet wird.

Um diese Schwachstelle auszunutzen, muss der Angreifer physischen Zugriff auf den betroffenen YubiKey haben. Der Angriff basiert auf sogenannten Seitenkanaltechniken, bei denen Informationen aus der Hardware durch physikalische Beobachtungen – wie Stromverbrauch oder elektromagnetische Emissionen – extrahiert werden. Auf diese Weise könnte es möglich sein, private Schlüssel zu rekonstruieren. Dafür ist jedoch hochgradig spezialisiertes technisches Know-how erforderlich – etwas, das ich derzeit nur großen Organisationen zutraue.

Es ist wichtig zu betonen:

- Ein Fernangriff ist nicht möglich. Der YubiKey muss sich physisch im Besitz des Angreifers befinden.

- Der Angriff ist komplex und erfordert spezielles Equipment sowie Fachwissen. Es handelt sich also nicht um eine triviale oder weit verbreitete Angriffsmethode.

- Nutzer können sich schützen, indem sie ihre YubiKeys sicher aufbewahren und den physischen Zugriff durch Dritte verhindern.

- Die Challenge-Response-Funktion des YubiKeys nutzt in der Regel HMAC-SHA1 oder HMAC-SHA256 zur Berechnung der Antworten. Da diese Funktion nicht auf ECDSA basiert, ist sie von der spezifischen Schwachstelle in der ECDSA-Implementierung nicht betroffen. Daher bleibt die Verwendung der Challenge-Response-Funktion mit KeePass auch bei älteren YubiKeys sicher.

Falls ein YubiKey verloren geht oder gestohlen wird, sollten betroffene Nutzer umgehend alle verknüpften Konten aktualisieren und den YubiKey aus den Sicherheitseinstellungen entfernen.

Natürlich ist es in jedem Fall ratsam, dies zu tun. Ein YubiKey – oder ähnliche Sicherheitstoken – sollte stets sicher aufbewahrt werden, ähnlich wie ein Haustürschlüssel. Allerdings bietet der YubiKey durch seine starke Authentifizierung ein höheres Maß an Sicherheit, da er – im Gegensatz zum Haustürschlüssel – nicht einfach "geknackt" werden kann. Ein Haustürschlüssel kann verloren gehen oder leicht kopiert werden – der YubiKey hingegen ist selbst bei Verlust schwer zu kompromittieren.

Ich möchte das nicht beschönigen – besonders, da Yubico meiner Meinung nach nicht angemessen auf diese Entdeckung reagiert hat. Angesichts der heutigen Komplexität ist es nahezu unvermeidlich, dass in jeder Hardware oder Software früher oder später Schwachstellen entdeckt werden. Deshalb sollte Software stets aktuell gehalten werden – ,,Never change a running system" ist heute schlicht fahrlässig. Sicherheits-Hardware, insbesondere wenn sie für sensible Daten genutzt wird, sollte alle paar Jahre ausgetauscht werden.

Gerade bei der Sicherheits-Hardware zeigt sich die Schwachstelle von Yubico – ironischerweise liegt sie in dem, was sonst die größte Stärke des YubiKeys ist. Ein Firmware-Update ist nicht möglich, da das Gerät nicht beschrieben werden kann. Dies verhindert zwar, dass Hacker eine eigene Firmware installieren, bedeutet aber auch, dass Sicherheitslücken nicht nachträglich geschlossen werden können. Es ist, als würde man die Tür zur Hölle versiegeln, aber dabei den Schlüssel zum Himmel verlieren.

Nun, wie hat Yubico darauf reagiert?

ZitatAb dem 21. Mai 2024 hat Yubico YubiKeys mit Firmware-Version 5.7 und neuer veröffentlicht. Diese Modelle nutzen eine eigene, verbesserte kryptografische Bibliothek und sind nicht von der Schwachstelle betroffen. Da ältere YubiKeys nicht durch Firmware-Updates aktualisiert werden können, rät Yubico Nutzern, ihre Geräte sicher aufzubewahren. Im Falle von Verlust oder Diebstahl sollten alle betroffenen Schlüssel umgehend aus den verbundenen Konten entfernt werden.

Für Nutzer mit höchsten Sicherheitsanforderungen empfiehlt es sich, auf die neuesten YubiKey-Modelle mit aktueller Firmware umzusteigen, um potenzielle Risiken zu minimieren.

Da dieses Risiko nach dem Common Vulnerability Scoring System (CVSS) als ,,moderat" eingestuft wurde und da der Besitz Ihres YubiKey und dessen sofortige Abmeldung bei Verlust oder Diebstahl dieses Risiko wirksam mindern kann, haben wir kein aktives Schlüsselersatzprogramm.

Gerade weil der YubiKey als besonders sicheres und vertrauenswürdiges Sicherheitsgerät beworben wird, ist es enttäuschend und frustrierend, dass der einzige Ausweg der Austausch gegen ein neueres Modell ist – da die Schwachstelle weder behoben noch per Patch geschlossen werden kann. Ein faires Angebot oder Rabatt für betroffene Kunden wäre hier zumindest angemessen gewesen.

Quellen:

#2

LINUX / Risiken der Cloud

Letzter Beitrag von Jo - 2025-01-08 | 19:12:21Die Risiken der Cloud: Warum eigene Backups und Verschlüsselung essenziell sind

In der heutigen digitalen Landschaft sind Cloud-Dienste wie Microsoft SharePoint, Google Drive und Apple iCloud weit verbreitet und bieten zahlreiche Vorteile hinsichtlich Zugänglichkeit und Zusammenarbeit. Dennoch gibt es berechtigte Bedenken hinsichtlich der Datensicherheit und des Datenschutzes, insbesondere wenn es um das Vertrauen in große Anbieter geht. In diesem Thread möchte ich meine Sichtweise teilen und erläutern, warum eigene Backups und Verschlüsselungsmaßnahmen unerlässlich sind, um die Sicherheit sensibler Daten zu gewährleisten. Zudem werde ich auf die Vorteile von Linux und Open-Source-Lösungen eingehen.

1. Skepsis gegenüber großen Cloud-Anbietern

Trotz der Behauptungen von Unternehmen wie Microsoft, Google und Apple, strenge Sicherheits- und Datenschutzstandards einzuhalten, bestehen oft Zweifel an der tatsächlichen Umsetzung dieser Versprechen, da diese Firmen dies nicht beweisen können oder wollen. Selbst Zertifizierungen durch unabhängige Dritte, sind Momentaufnahmen und bieten nur ein begrenztes Maß an Vertrauen (dasselbe gilt auch für VPN-Anbieter). Daher ist es nicht ausreichend, sich ausschließlich auf solche Dienste zu verlassen, und bei sensiblen Daten sogar völlig unzureichend. Jeder sollte damit kalkulieren, dass solch ein Dienst, egal, was diese versprechen, eure Daten lesen oder zumindest auswerten kann. Zudem besteht die Gefahr, dass diese euch, aus welchen Gründen auch immer, aussperren können. Selbst teure und sehr aufwändige Hackerangriffe sind aufgrund der Größe und der vielen Nutzer wahrscheinlicher als Angriffe auf private Nutzer oder kleine Unternehmen.

2. Bedeutung von eigenen Backups

Eigene Backups sind essenziell, um sicherzustellen, dass wichtige Daten nicht verloren gehen. Zudem sollten diese physisch keine dauerhafte Verbindung zum Rechner oder eurem Netzwerk haben, außer wenn ein Backup läuft. Cloud-Anbieter bieten zwar Recycle-Bins und Wiederherstellungsoptionen, diese sollten jedoch nicht als einzige Schutzmaßnahme betrachtet werden. Durch die Erstellung von Backups auf eigenen Datenträgern oder alternativen Lösungen wie einer eigenen Nextcloud oder Server behält man die vollständige Kontrolle über die eigenen Daten und minimiert das Risiko eines dauerhaften Datenverlusts.

3. Implementierung von Zero-Trust-Prinzipien

Das Zero-Trust-Modell basiert auf der Annahme, dass weder innerhalb noch außerhalb des Netzwerks automatisch vertraut wird. Dies beinhaltet:

4. Keep It Simple (KIS) Prinzip

Keep It Simple zielt darauf ab, Systeme und Prozesse so einfach wie möglich zu gestalten. In Bezug auf die IT-Sicherheit bedeutet dies:

5. Vorteile von Open-Source-Lösungen und Linux

Open-Source-Lösungen bieten mehr Transparenz, da der Quellcode öffentlich zugänglich ist und von der Community geprüft werden kann. Beispiele hierfür sind:

Es ist jedoch wichtig zu beachten, dass Open-Source-Software nicht automatisch 100 % sicher ist. Die Sicherheit hängt von der aktiven Wartung und Prüfung durch die Community ab und davon, dass Programme nur aus sicheren Quellen installiert werden. Dennoch bieten Open-Source-Lösungen tendenziell höhere Sicherheit durch Transparenz und die Möglichkeit, den Code selbst zu überprüfen, auch wenn dies für die meisten Nutzer aufgrund fehlender Programmierkenntnisse oder der Komplexität des Quellcodes nicht realisierbar ist.

6. Eigene Verschlüsselung als zusätzliche Sicherheitsmaßnahme

Die Verschlüsselung eigener Daten vor dem Hochladen in die Cloud bietet eine zusätzliche Sicherheitsebene. Tools wie VeraCrypt, GnuPG oder OpenSSL können verwendet werden, um Daten lokal zu verschlüsseln. Dies stellt sicher, dass nur autorisierte Personen mit dem richtigen Passwort Zugriff auf die Daten haben, selbst wenn sie auf den Servern des Cloud-Anbieters gespeichert sind.

Empfohlene Maßnahmen für maximale Datensicherheit

Fazit

Die Kombination aus Zero-Trust-Prinzipien, Keep It Simple, Open-Source-Lösungen, Programmen aus sicheren Quellen sowie zusätzlichen Sicherheitsmaßnahmen wie eigener Verschlüsselung und regelmäßigen Backups bildet eine robuste Strategie zur Datensicherheit. Während große Cloud-Anbieter wie Microsoft, Google und Apple nützliche Tools und Dienste bereitstellen, ist es entscheidend, nicht ausschließlich darauf zu vertrauen. Durch den Einsatz eigener Maßnahmen, die Nutzung von Open-Source-Lösungen und die Bevorzugung von sicheren Betriebssystemen wie Linux kann man die Kontrolle über die eigenen Daten maximieren und die Risiken eines Datenverlusts oder unautorisierten Zugriffs minimieren.

Jedoch bleibt am Ende immer das unberechenbare Problem zwischen Stuhl und Bildschirm bestehen. Bleibt wachsam!

Deine Sicherheit sollte immer in deinen eigenen Händen liegen – kein Backup? Kein Mitleid.

Stand: 2025-Januar

In der heutigen digitalen Landschaft sind Cloud-Dienste wie Microsoft SharePoint, Google Drive und Apple iCloud weit verbreitet und bieten zahlreiche Vorteile hinsichtlich Zugänglichkeit und Zusammenarbeit. Dennoch gibt es berechtigte Bedenken hinsichtlich der Datensicherheit und des Datenschutzes, insbesondere wenn es um das Vertrauen in große Anbieter geht. In diesem Thread möchte ich meine Sichtweise teilen und erläutern, warum eigene Backups und Verschlüsselungsmaßnahmen unerlässlich sind, um die Sicherheit sensibler Daten zu gewährleisten. Zudem werde ich auf die Vorteile von Linux und Open-Source-Lösungen eingehen.

1. Skepsis gegenüber großen Cloud-Anbietern

Trotz der Behauptungen von Unternehmen wie Microsoft, Google und Apple, strenge Sicherheits- und Datenschutzstandards einzuhalten, bestehen oft Zweifel an der tatsächlichen Umsetzung dieser Versprechen, da diese Firmen dies nicht beweisen können oder wollen. Selbst Zertifizierungen durch unabhängige Dritte, sind Momentaufnahmen und bieten nur ein begrenztes Maß an Vertrauen (dasselbe gilt auch für VPN-Anbieter). Daher ist es nicht ausreichend, sich ausschließlich auf solche Dienste zu verlassen, und bei sensiblen Daten sogar völlig unzureichend. Jeder sollte damit kalkulieren, dass solch ein Dienst, egal, was diese versprechen, eure Daten lesen oder zumindest auswerten kann. Zudem besteht die Gefahr, dass diese euch, aus welchen Gründen auch immer, aussperren können. Selbst teure und sehr aufwändige Hackerangriffe sind aufgrund der Größe und der vielen Nutzer wahrscheinlicher als Angriffe auf private Nutzer oder kleine Unternehmen.

2. Bedeutung von eigenen Backups

Eigene Backups sind essenziell, um sicherzustellen, dass wichtige Daten nicht verloren gehen. Zudem sollten diese physisch keine dauerhafte Verbindung zum Rechner oder eurem Netzwerk haben, außer wenn ein Backup läuft. Cloud-Anbieter bieten zwar Recycle-Bins und Wiederherstellungsoptionen, diese sollten jedoch nicht als einzige Schutzmaßnahme betrachtet werden. Durch die Erstellung von Backups auf eigenen Datenträgern oder alternativen Lösungen wie einer eigenen Nextcloud oder Server behält man die vollständige Kontrolle über die eigenen Daten und minimiert das Risiko eines dauerhaften Datenverlusts.

3. Implementierung von Zero-Trust-Prinzipien

Das Zero-Trust-Modell basiert auf der Annahme, dass weder innerhalb noch außerhalb des Netzwerks automatisch vertraut wird. Dies beinhaltet:

- Strikte Authentifizierung und Autorisierung: Jede Anfrage nach Zugriff muss verifiziert werden, unabhängig von ihrer Herkunft.

- Minimierung von Zugriffsrechten: Benutzer und Systeme erhalten nur die minimal notwendigen Berechtigungen.

- Netzwerksegmentierung: Aufteilung des Netzwerks in kleinere, isolierte Segmente zur Eindämmung potenzieller Angriffe.

- Kontinuierliche Überwachung: Ständige Analyse des Netzwerkverkehrs und der Benutzeraktivitäten zur schnellen Erkennung verdächtigen Verhaltens.

4. Keep It Simple (KIS) Prinzip

Keep It Simple zielt darauf ab, Systeme und Prozesse so einfach wie möglich zu gestalten. In Bezug auf die IT-Sicherheit bedeutet dies:

- Reduzierung der Komplexität: Einfachere Systeme sind weniger fehleranfällig und leichter zu verwalten.

- Verminderung der Angriffsfläche: Weniger Komponenten bedeuten weniger potenzielle Schwachstellen.

- Erhöhte Benutzerfreundlichkeit: Leicht verständliche Sicherheitslösungen fördern die korrekte Nutzung durch die Benutzer.

5. Vorteile von Open-Source-Lösungen und Linux

Open-Source-Lösungen bieten mehr Transparenz, da der Quellcode öffentlich zugänglich ist und von der Community geprüft werden kann. Beispiele hierfür sind:

- Nextcloud: Eine Alternative zu proprietären Datei-Hosting-Diensten, die vollständige Kontrolle über die eigenen Daten ermöglicht.

- Cryptomator: Ein Tool zur Verschlüsselung von Cloud-Daten vor dem Hochladen.

- Linux: Ein Open-Source-Betriebssystem, das für seine Sicherheit, Stabilität und Anpassungsfähigkeit bekannt ist. Linux bietet eine robuste Grundlage für den Schutz sensibler Daten und die Implementierung eigener Sicherheitslösungen.

Es ist jedoch wichtig zu beachten, dass Open-Source-Software nicht automatisch 100 % sicher ist. Die Sicherheit hängt von der aktiven Wartung und Prüfung durch die Community ab und davon, dass Programme nur aus sicheren Quellen installiert werden. Dennoch bieten Open-Source-Lösungen tendenziell höhere Sicherheit durch Transparenz und die Möglichkeit, den Code selbst zu überprüfen, auch wenn dies für die meisten Nutzer aufgrund fehlender Programmierkenntnisse oder der Komplexität des Quellcodes nicht realisierbar ist.

6. Eigene Verschlüsselung als zusätzliche Sicherheitsmaßnahme

Die Verschlüsselung eigener Daten vor dem Hochladen in die Cloud bietet eine zusätzliche Sicherheitsebene. Tools wie VeraCrypt, GnuPG oder OpenSSL können verwendet werden, um Daten lokal zu verschlüsseln. Dies stellt sicher, dass nur autorisierte Personen mit dem richtigen Passwort Zugriff auf die Daten haben, selbst wenn sie auf den Servern des Cloud-Anbieters gespeichert sind.

Empfohlene Maßnahmen für maximale Datensicherheit

- Eigene Backups erstellen: Ergänze die Cloud-Dienste mit lokalen Backups (z.B. externen USB-C SSDs) oder alternativen Cloud-Backups wie Nextcloud.

- Starke Verschlüsselung verwenden: Verschlüssele sensible Daten mit robusten Methoden und sicheren Passwörtern.

- Zero-Trust-Prinzipien anwenden: Implementiere strenge Authentifizierungs- und Autorisierungsmaßnahmen sowie kontinuierliche Überwachung.

- Systeme einfach halten: Reduziere die Komplexität der Sicherheitslösungen, um Fehler zu minimieren und die Verwaltung zu erleichtern.

- Open-Source-Lösungen und Linux nutzen: Setze auf transparente und überprüfbare Software sowie ein sicheres Betriebssystem, um das Vertrauen in die Sicherheitsmaßnahmen zu erhöhen.

- Regelmäßige Überprüfung: Überprüfe und aktualisiere regelmäßig die Sicherheitsrichtlinien und -praktiken.

Fazit

Die Kombination aus Zero-Trust-Prinzipien, Keep It Simple, Open-Source-Lösungen, Programmen aus sicheren Quellen sowie zusätzlichen Sicherheitsmaßnahmen wie eigener Verschlüsselung und regelmäßigen Backups bildet eine robuste Strategie zur Datensicherheit. Während große Cloud-Anbieter wie Microsoft, Google und Apple nützliche Tools und Dienste bereitstellen, ist es entscheidend, nicht ausschließlich darauf zu vertrauen. Durch den Einsatz eigener Maßnahmen, die Nutzung von Open-Source-Lösungen und die Bevorzugung von sicheren Betriebssystemen wie Linux kann man die Kontrolle über die eigenen Daten maximieren und die Risiken eines Datenverlusts oder unautorisierten Zugriffs minimieren.

Jedoch bleibt am Ende immer das unberechenbare Problem zwischen Stuhl und Bildschirm bestehen. Bleibt wachsam!

Deine Sicherheit sollte immer in deinen eigenen Händen liegen – kein Backup? Kein Mitleid.

#3

LINUX / TRIM-Probleme mit externer SSD...

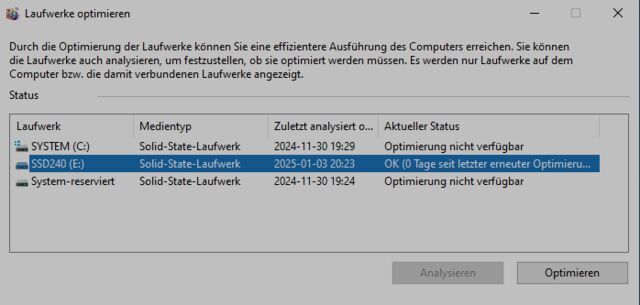

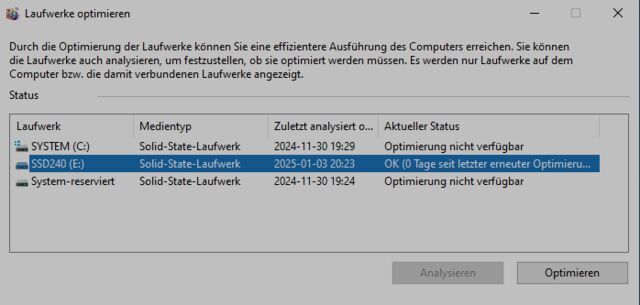

Letzter Beitrag von Jo - 2025-01-03 | 22:12:45TRIM-Probleme mit externer SSD (JMS583 Controller) – Unterschiede zwischen Linux (Kernel 6.6) und Windows 10/11

Stand: 2025-Januar

Hallo, hier meine Erfahrungen mit TRIM und einer externen SSD in einem ElecGear USB Mini Gehäuse (JMS583 Controller). Vielleicht hilft das jemandem, der vor ähnlichen Herausforderungen steht.

Setup:

Problem:

Obwohl der JMS583-Controller, nach dem Erstellen einer udev-Regel, laut 'lsblk' TRIM unterstützt, funktioniert 'fstrim' unter Linux nicht für die NTFS-formatierte SSD.

Befehle und Ausgaben:

TRIM wird zwar unterstützt, aber beim Versuch, 'fstrim' auszuführen, erscheint:

Ein Check mit 'hdparm' zeigt keine TRIM-Unterstützung:

Zusätzliche Tests:

'lsusb -t' zeigt: UASP ist aktiv.

Auch in einer VM mit Windows 10 auf Manjaro kann ich TRIM ausführen.

Vermutung:

Lösung:

Ich habe die SSD unter Windows 10 mit exFAT formatiert – damit funktioniert TRIM unter Linux und Windows.

Prüfung der Partitionierung mit Linux nach exFAT-Formatierung unter Windows 10:

TRIM:

Interessantes Verhalten:

Fazit:

Falls jemand ähnliche Erfahrungen gemacht hat oder eine bessere Lösung kennt, freue ich mich über ein Feedback per Matrix!

Stand: 2025-Januar

Hallo, hier meine Erfahrungen mit TRIM und einer externen SSD in einem ElecGear USB Mini Gehäuse (JMS583 Controller). Vielleicht hilft das jemandem, der vor ähnlichen Herausforderungen steht.

Setup:

- SSD: Samsung 256GB M.2 2242 (NVMe)

- Gehäuse: ElecGear USB Mini für 2230/2242 NVMe und SATA M.2 SSDs

- Controller: JMS583 (USB 3.1 Gen2 zu PCIe Gen3 x2)

- Einsatz: Multiboot-Umgebung (Windows 10/11, Manjaro Linux)

- Dateisystem (anfangs): NTFS

Problem:

Obwohl der JMS583-Controller, nach dem Erstellen einer udev-Regel, laut 'lsblk' TRIM unterstützt, funktioniert 'fstrim' unter Linux nicht für die NTFS-formatierte SSD.

Befehle und Ausgaben:

Code Auswählen

lsblk --discard /dev/sda

NAME DISC-ALN DISC-GRAN DISC-MAX DISC-ZERO

sda 0 4K 4G 0

└─sda1 0 4K 4G 0TRIM wird zwar unterstützt, aber beim Versuch, 'fstrim' auszuführen, erscheint:

Code Auswählen

sudo fstrim -v /run/media/jo/SSD256/

fstrim: /run/media/jo/SSD256/: Verwerfungsvorgang wird nicht unterstützt.Ein Check mit 'hdparm' zeigt keine TRIM-Unterstützung:

Code Auswählen

sudo hdparm -I /dev/sda | grep -i trim

# Leere AusgabeZusätzliche Tests:

'lsusb -t' zeigt: UASP ist aktiv.

Code Auswählen

...

|__ Port 003: Dev 007, If 0, Class=Mass Storage, Driver=uas, 5000M

...Unter Windows 11 funktioniert TRIM (Laufwerk optimieren).Auch in einer VM mit Windows 10 auf Manjaro kann ich TRIM ausführen.

Vermutung:

- Windows unterstützt TRIM für NTFS nativ, während dies unter Linux möglicherweise eingeschränkt ist.

- Samsung T3 (auch mit NTFS) lässt sich unter Linux trimmen, daher könnte es am JMS583-Controller oder der SSD-Firmware liegen.

- Oder es liegt an einer Inkompatibilität der Flags (msftdata) oder der Partitionstabelle (GPT/MBR).

Lösung:

Ich habe die SSD unter Windows 10 mit exFAT formatiert – damit funktioniert TRIM unter Linux und Windows.

Prüfung der Partitionierung mit Linux nach exFAT-Formatierung unter Windows 10:

Code Auswählen

sudo parted /dev/sda print

Modell: NV-2242A (scsi)

Festplatte /dev/sda: 256GB

Sektorgröße (logisch/physisch): 512B/4096B

Partitionstabelle: gpt

Disk-Flags:

Nummer Anfang Ende Größe Dateisystem Name Flags

1 17,4kB 256GB 256GB msftdataWichtige Informationen wie Partitionstyp (GPT/MBR), Dateisystem und gesetzte Flags (z. B. msftdata) werden angezeigt.TRIM:

Code Auswählen

sudo fstrim -v /run/media/jo/SSD256/

/run/media/jo/SSD256/: 184,4 GiB (198023577600 Bytes) getrimmtInteressantes Verhalten:

- Wenn ich die SSD unter Linux mit exFAT formatiere, wird sie von Windows 10 nicht erkannt und Windows verlangt eine Neuformatierung.

- Formatierung unter Windows 10 behebt das Problem und macht die SSD plattformübergreifend nutzbar.

Fazit:

- TRIM für NTFS auf externen SSDs unter Linux ist unzuverlässig, je nach SSD-Controller und Firmware.

- exFAT ist eine gute Alternative, aber die Formatierung sollte unter Windows erfolgen, um maximale Kompatibilität zu gewährleisten.

- Möglicherweise gibt es Unterschiede in der exFAT-Implementierung zwischen Linux und Windows.

Falls jemand ähnliche Erfahrungen gemacht hat oder eine bessere Lösung kennt, freue ich mich über ein Feedback per Matrix!

#4

RustDesk ist eine kostenlose Open-Source-Alternative zu TeamViewer und AnyDesk, die sicheren Fernzugriff mit Ende-zu-Ende-Verschlüsselung bietet. Für maximale Kontrolle und Datensicherheit kann optional ein eigener Server betrieben werden. Wer RustDesk beispielsweise auf einem Raspberry Pi einrichtet und die Verbindung über ein VPN absichert, steigert die Sicherheit zusätzlich.

Der öffentliche Relay-Server ist kostenlos, bietet aber keine direkte Kontrolle. Die Einrichtung eines eigenen Servers erfordert zwar etwas Aufwand, bietet jedoch mehr Sicherheit und Kontrolle. Auch ohne eigenen Server bleibt RustDesk durch Verschlüsselung und Open-Source-Transparenz sicherer als viele kommerzielle Alternativen – ohne kommerzielle Interessen an Nutzerdaten.

Link: github.com/rustdesk/rustdesk

Hinweis: RustDesk benötigt Docker oder läuft direkt als Binary (RustDesk Server hbbs und hbbr).

Die Software ist plattformübergreifend verfügbar und läuft auf Windows, macOS, Linux sowie auf mobilen Geräten mit Android und iOS. Sie ermöglicht nicht nur Fernsteuerung, sondern auch Dateiübertragungen und unterstützt Chat während der Verbindung. RustDesk ist eine vielversprechende Lösung für datenschutzbewusste Nutzer, die eine einfache, flexible und kostengünstige Remote-Desktop-Lösung suchen.

Rustdesk über flathub installieren:

Rustdesk starten:

Die Homepage von RustDesk warnt dich sogar vor Betrügern mit dieser Meldung:

Diese klare Warnung zeigt, dass RustDesk sich aktiv für die Sicherheit seiner Nutzer einsetzt. Diese Warnung sollte natürlich für alle Remote-Desktop-Programme und im Umgang mit unseriösen Anrufern gelten.

Du kannst RustDesk, das du mit Flatpak installiert hast, ganz einfach mit folgendem Befehl deinstallieren:

Falls du sicherstellen möchtest, dass wirklich alle Daten und Berechtigungen entfernt werden, kannst du den Befehl erweitern:

Anschließend kannst du nicht mehr benötigte Reste mit diesem Befehl aufräumen:

Falls du dir unsicher bist, welche Flatpak-Apps installiert sind, kannst du eine Liste anzeigen lassen:

Der öffentliche Relay-Server ist kostenlos, bietet aber keine direkte Kontrolle. Die Einrichtung eines eigenen Servers erfordert zwar etwas Aufwand, bietet jedoch mehr Sicherheit und Kontrolle. Auch ohne eigenen Server bleibt RustDesk durch Verschlüsselung und Open-Source-Transparenz sicherer als viele kommerzielle Alternativen – ohne kommerzielle Interessen an Nutzerdaten.

Link: github.com/rustdesk/rustdesk

Hinweis: RustDesk benötigt Docker oder läuft direkt als Binary (RustDesk Server hbbs und hbbr).

Die Software ist plattformübergreifend verfügbar und läuft auf Windows, macOS, Linux sowie auf mobilen Geräten mit Android und iOS. Sie ermöglicht nicht nur Fernsteuerung, sondern auch Dateiübertragungen und unterstützt Chat während der Verbindung. RustDesk ist eine vielversprechende Lösung für datenschutzbewusste Nutzer, die eine einfache, flexible und kostengünstige Remote-Desktop-Lösung suchen.

Rustdesk über flathub installieren:

Code Auswählen

flatpak install flathub com.rustdesk.RustDeskRustdesk starten:

Code Auswählen

flatpak run com.rustdesk.RustDeskDie Homepage von RustDesk warnt dich sogar vor Betrügern mit dieser Meldung:

ZitatWARNUNG: Jemand könnte dich gerade betrügen!

Wenn du gerade mit jemandem telefonierst, den du nicht kennst und nicht vertraust – und diese Person möchte, dass du RustDesk installierst – dann installiere es nicht und lege sofort auf! Mit hoher Wahrscheinlichkeit sind dies Betrüger, die versuchen, dein Geld oder private Informationen zu stehlen.

Diese klare Warnung zeigt, dass RustDesk sich aktiv für die Sicherheit seiner Nutzer einsetzt. Diese Warnung sollte natürlich für alle Remote-Desktop-Programme und im Umgang mit unseriösen Anrufern gelten.

Du kannst RustDesk, das du mit Flatpak installiert hast, ganz einfach mit folgendem Befehl deinstallieren:

Code Auswählen

flatpak uninstall com.rustdesk.RustDeskFalls du sicherstellen möchtest, dass wirklich alle Daten und Berechtigungen entfernt werden, kannst du den Befehl erweitern:

Code Auswählen

flatpak uninstall --delete-data com.rustdesk.RustDeskAnschließend kannst du nicht mehr benötigte Reste mit diesem Befehl aufräumen:

Code Auswählen

flatpak remove --unusedFalls du dir unsicher bist, welche Flatpak-Apps installiert sind, kannst du eine Liste anzeigen lassen:

Code Auswählen

flatpak list

#5

LINUX / Status und Updates zu Manjaro ...

Letzter Beitrag von Jo - 2024-10-26 | 13:18:59Stand: 2024-10-26

Normalerweise wurde der Manjaro ARM Stable Branch etwa alle zwei Monate aktualisiert. Aufgrund der Verzögerungen bei der ALARM-Aktivität dauert es jedoch derzeit etwas länger. Es könnte sich bald ändern, da geplant ist, das alte boxit-System durch bxt zu ersetzen. Mehr dazu im Video: Manjaro's Weg in die Zukunft.

Da die ARM-Architektur weniger genutzt wird, fehlt es aktuell an Zeit und Ressourcen, um regelmäßige Updates zu liefern. Dennoch hat das Manjaro-Team am 26.10.2024 den ARM-Testing Branch aktualisiert. Siehe auch: Status of ARM Stable Updates: No Major Update Since March 2024?

Dieses Update enthält unter anderem ein wichtiges Update für den ioBroker: Die Version von nodejs-lts-iron wurde von 20.12.2-1 auf 20.18.0-1 aktualisiert. Der Hauptunterschied zwischen den Node.js-Versionen liegt in einigen wichtigen Optimierungen, besonders der Performance und Fehlerbehebungen.

Wer das Update testen möchte, sollte zuvor ein aktuelles ioBroker-Backup erstellen. Der Wechsel des Branches ist mit einer Zeile einfach (siehe auch: Wiki Manjaro - Switching_Branches):

Wechseln von Stable zu Testing

Code Auswählen

sudo pacman-mirrors -aS testing && sudo pacman-mirrors --country Germany,France,Austria && sudo pacman -SyyuWechseln von Testing zu StableCode Auswählen

sudo pacman-mirrors -aS stable && sudo pacman-mirrors --country Germany,France,Austria && sudo pacman -SyyuStatt "--country Germany,France,Austria" könnte auch "--fasttrack" eine sinnvolle Option sein.

Überprüfen, welchen Branch dein System derzeit verwendet

Code Auswählen

pacman-mirrors -GOptional: Kontrolliere die pacman-Konfigurationsdatei

Code Auswählen

nano /etc/pacman-mirrors.confHinweis: Nach dem Wechsel zu einem stabileren Branch kann pacman Meldungen anzeigen, dass neuere Pakete installiert sind als im Repository verfügbar. Dies ist unproblematisch, da sich die Situation von selbst löst, sobald die Pakete den aktuellen Zweig erreichen. Alternativ kann der Befehl "sudo pacman -Syyuu" verwendet werden, um pacman anzuweisen, die Paketdatenbanken vollständig zu synchronisieren und Downgrades durchzuführen, sodass alle Pakete auf die Versionen im Stable Branch zurückgesetzt werden. Anschließend das System neu starten, um sicherzustellen, dass alle Änderungen korrekt übernommen wurden.

Der Testing Branch ist natürlich – abgesehen von Stable – die sicherere Wahl: Nach einer ersten Überprüfung im Unstable Branch werden stabile Pakete in den Testing Branch verschoben. Hier haben sie bereits eine grundlegende Stabilitätsprüfung durchlaufen, werden jedoch weiterhin von der Community getestet. Es ist daher wichtig, sich im entsprechenden Testing Beitrag im Forum einzulesen und eventuelle Probleme dort zu melden.

Was ist der Unstable Branch? Auch wenn der Begriff ,,unstable" irreführend klingen mag – die Pakete aus Arch Linux funktionieren in der Regel zuverlässig – kann es gelegentlich notwendig sein, manuell einzugreifen, um Probleme zu beheben. Daher ist dieser Branch für Anfänger weniger geeignet. Im Unstable-Branch erscheinen neue Pakete zuerst, direkt nachdem sie aus Arch Linux übernommen wurden. Sie enthalten die neuesten Änderungen, bringen jedoch ein höheres Risiko für Bugs mit sich.

Auf meinem Test-Pi4 wurden nach der Umstellung vom Stable- auf den Testing-Branch 222 Pakete aktualisiert:

Code Auswählen

$ neofetch

██████████████████ ████████ pi4m@manjaro-test

██████████████████ ████████ -----------------

██████████████████ ████████ OS: Manjaro ARM Linux aarch64

██████████████████ ████████ Host: Raspberry Pi 4 Model B Rev 1.4

████████ ████████ Kernel: 6.6.58-1-MANJARO-RPI4

████████ ████████ ████████ Uptime: 42 secs

████████ ████████ ████████ Packages: 275 (pacman)

████████ ████████ ████████ Shell: bash 5.2.37

████████ ████████ ████████ Terminal: /dev/pts/0

████████ ████████ ████████ CPU: (4) @ 1.500GHz

████████ ████████ ████████ Memory: 142MiB / 7806MiB

████████ ████████ ████████

████████ ████████ ████████

████████ ████████ ████████

$ type -P nodejs node npm npx && nodejs -v && node -v && npm -v && npx -v

/usr/bin/nodejs

/usr/bin/node

/usr/bin/npm

/usr/bin/npx

v20.18.0

v20.18.0

10.9.0

10.9.0

Meine Umstellung auf den Unstable-Branch (Stand: 12. Januar 2025) installiert einen aktuellen Kernel (kein LTS-Kernel) sowie eine neuere Version von Node.js. Hinweis: Diese Konfiguration ist nicht für Einsteiger geeignet!

Code Auswählen

neofetch

██████████████████ ████████ pi4m@manjaro-arm

██████████████████ ████████ ----------------

██████████████████ ████████ OS: Manjaro ARM Linux aarch64

██████████████████ ████████ Host: Raspberry Pi 4 Model B Rev 1.5

████████ ████████ Kernel: 6.12.9-1-MANJARO-RPI4

████████ ████████ ████████ Uptime: 8 mins

████████ ████████ ████████ Packages: 320 (pacman)

████████ ████████ ████████ Shell: bash 5.2.37

████████ ████████ ████████ Terminal: /dev/pts/0

████████ ████████ ████████ CPU: (4) @ 1.500GHz

████████ ████████ ████████ Memory: 1170MiB / 7798MiB

████████ ████████ ████████

████████ ████████ ████████

████████ ████████ ████████

[pi4m@manjaro-arm ~]$ type -P nodejs node npm npx && nodejs -v && node -v && npm -v && npx -v

/usr/bin/nodejs

/usr/bin/node

/usr/bin/npm

/usr/bin/npx

v20.18.1

v20.18.1

10.9.2

10.9.2

#6

LINUX / Antw:Linux: Wichtige Entscheid...

Letzter Beitrag von Jo - 2024-10-01 | 20:39:222024-10-01 Großes Update! Manjaro 24.1.0 (Xahea) mit Plasma 6.1.5

Link: forum.manjaro.org

1) pulseaudio-ctl wurde in die AUR verschoben. Es dient dazu, die Lautstärke und andere Audio-Einstellungen direkt über das Terminal zu steuern. Da ich es nicht benötige, habe ich das Paket deinstalliert:

2) Für VirtualBox 7.1 wird das passende Oracle VirtualBox Extension Pack benötigt. Stelle sicher, dass du die Datei Oracle_VirtualBox_Extension_Pack-7.1.0.vbox-extpack installierst. Die schwebende Kontrollleiste unter Plasma sollte deaktiviert werden, um instabile oder ruckelnde Fenster zu vermeiden.

3) Der Video-Editor Kdenlive benötigt ein 'opencv' Update (2024-10-02).

Link: forum.manjaro.org

1) pulseaudio-ctl wurde in die AUR verschoben. Es dient dazu, die Lautstärke und andere Audio-Einstellungen direkt über das Terminal zu steuern. Da ich es nicht benötige, habe ich das Paket deinstalliert:

Code Auswählen

sudo pacman -Rns pulseaudio-ctl2) Für VirtualBox 7.1 wird das passende Oracle VirtualBox Extension Pack benötigt. Stelle sicher, dass du die Datei Oracle_VirtualBox_Extension_Pack-7.1.0.vbox-extpack installierst. Die schwebende Kontrollleiste unter Plasma sollte deaktiviert werden, um instabile oder ruckelnde Fenster zu vermeiden.

3) Der Video-Editor Kdenlive benötigt ein 'opencv' Update (2024-10-02).

#7

LINUX / 2024-August Branch-Namen in Gi...

Letzter Beitrag von Jo - 2024-08-20 | 22:18:572024-August Branch-Namen in Git-Repositories bei AUR-Paketen

Die Git-Meldung beim AUR-Update ist unbedenklich und erfordert keine manuelle Anpassung, da sie nur ein Hinweis ist und die Funktionalität der Pakete nicht beeinträchtigt. Wenn dich die Meldung stört, kannst du sicherstellen, dass dein System den Standard-Branch global auf "main" setzt.

Erläuterung der Git-Meldung bei der Verwendung von AUR-Paketen unter Manjaro

Die Meldung, die du unter Manjaro erhältst, bezieht sich auf eine Änderung im Umgang mit den Standard-Branch-Namen in Git, die seit einigen Jahren eingeführt wurde. Sie hat direkt nichts mit dem eigentlichen Update-Prozess von AUR-Paketen zu tun, sondern ist eine allgemeine Information, die Git ausgibt, wenn es bei der Installation oder dem Update eines Pakets verwendet wird.

Traditionell war der Standard-Branch-Name in Git "master". Aufgrund der zunehmenden Sensibilität gegenüber der Sprache und um Git inklusiver zu gestalten, wurde entschieden, dass neue Repositories einen flexibleren Standard-Branch-Namen haben sollten. Die Git-Entwickler haben "main" als neuen Standard-Branch-Namen vorgeschlagen, aber du kannst auch einen anderen Namen wählen, wie "trunk", "development" oder einen beliebigen Namen, der dir passt.

Die Meldung, die du siehst, weist dich darauf hin, dass Git immer noch "master" als Standard-Branch-Namen verwendet, wenn du ein neues Repository initialisierst, und informiert dich darüber, wie du diesen Standard-Branch-Namen global ändern kannst.

Um diese Meldung in Zukunft zu vermeiden und einen anderen Standard-Branch-Namen zu verwenden, kannst du den vorgeschlagenen Befehl ausführen:

Damit wird der Branch-Name für alle neuen Repositories, die du initialisierst, auf "main" gesetzt. Natürlich kannst du anstelle von "main" auch jeden anderen Branch-Namen verwenden, den du bevorzugst.

Um zu überprüfen, ob die Konfiguration korrekt gespeichert wurde, kannst du den folgenden Befehl eingeben:

Dieser Befehl zeigt den aktuellen Wert der Einstellung an. Wenn alles korrekt konfiguriert wurde, sollte die Ausgabe "main" sein. Die Einstellung wird in der globalen Git-Konfigurationsdatei gespeichert, die sich in deinem Home-Verzeichnis befindet und '.gitconfig' heißt.

ZitatHinweis: Als Name für den initialen Branch wurde 'master' benutzt. Dieser

Hinweis: Standard-Branchname kann sich ändern. Um den Namen des initialen Branches

Hinweis: zu konfigurieren, der in allen neuen Repositories verwendet werden soll und

Hinweis: um diese Warnung zu unterdrücken, führen Sie aus:

Hinweis:

Hinweis: git config --global init.defaultBranch <Name>

Hinweis:

Hinweis: Häufig gewählte Namen statt 'master' sind 'main', 'trunk' und

Hinweis: 'development'. Der gerade erstellte Branch kann mit diesem Befehl

Hinweis: umbenannt werden:

Hinweis:

Hinweis: git branch -m <Name>

Die Git-Meldung beim AUR-Update ist unbedenklich und erfordert keine manuelle Anpassung, da sie nur ein Hinweis ist und die Funktionalität der Pakete nicht beeinträchtigt. Wenn dich die Meldung stört, kannst du sicherstellen, dass dein System den Standard-Branch global auf "main" setzt.

Erläuterung der Git-Meldung bei der Verwendung von AUR-Paketen unter Manjaro

Die Meldung, die du unter Manjaro erhältst, bezieht sich auf eine Änderung im Umgang mit den Standard-Branch-Namen in Git, die seit einigen Jahren eingeführt wurde. Sie hat direkt nichts mit dem eigentlichen Update-Prozess von AUR-Paketen zu tun, sondern ist eine allgemeine Information, die Git ausgibt, wenn es bei der Installation oder dem Update eines Pakets verwendet wird.

Traditionell war der Standard-Branch-Name in Git "master". Aufgrund der zunehmenden Sensibilität gegenüber der Sprache und um Git inklusiver zu gestalten, wurde entschieden, dass neue Repositories einen flexibleren Standard-Branch-Namen haben sollten. Die Git-Entwickler haben "main" als neuen Standard-Branch-Namen vorgeschlagen, aber du kannst auch einen anderen Namen wählen, wie "trunk", "development" oder einen beliebigen Namen, der dir passt.

Die Meldung, die du siehst, weist dich darauf hin, dass Git immer noch "master" als Standard-Branch-Namen verwendet, wenn du ein neues Repository initialisierst, und informiert dich darüber, wie du diesen Standard-Branch-Namen global ändern kannst.

Um diese Meldung in Zukunft zu vermeiden und einen anderen Standard-Branch-Namen zu verwenden, kannst du den vorgeschlagenen Befehl ausführen:

Code Auswählen

git config --global init.defaultBranch mainDamit wird der Branch-Name für alle neuen Repositories, die du initialisierst, auf "main" gesetzt. Natürlich kannst du anstelle von "main" auch jeden anderen Branch-Namen verwenden, den du bevorzugst.

Um zu überprüfen, ob die Konfiguration korrekt gespeichert wurde, kannst du den folgenden Befehl eingeben:

Code Auswählen

git config --global init.defaultBranchDieser Befehl zeigt den aktuellen Wert der Einstellung an. Wenn alles korrekt konfiguriert wurde, sollte die Ausgabe "main" sein. Die Einstellung wird in der globalen Git-Konfigurationsdatei gespeichert, die sich in deinem Home-Verzeichnis befindet und '.gitconfig' heißt.

#8

LINUX / Anytype - Notiz- und Projektma...

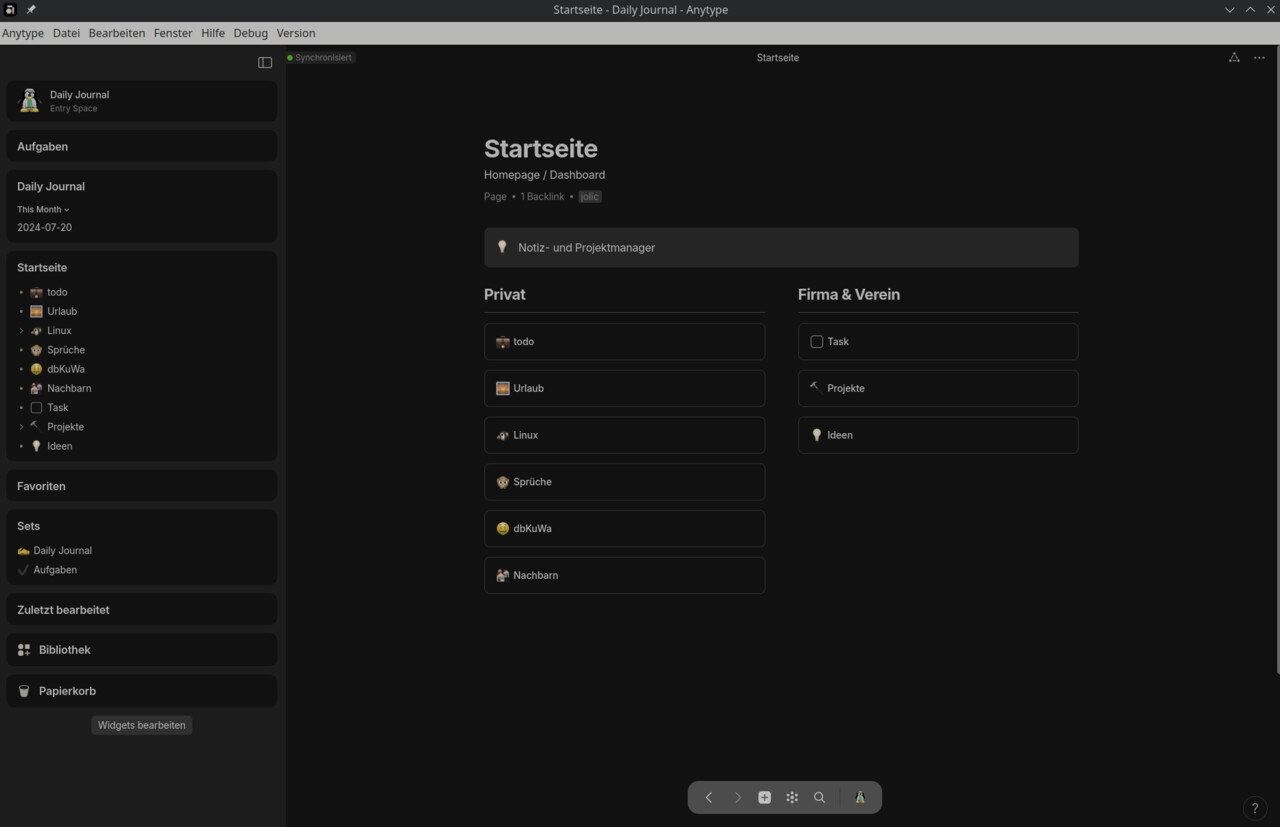

Letzter Beitrag von Jo - 2024-07-21 | 10:02:28Anytype.io ist eine vielversprechende Alternative zu Notion und anderen Notiz- und Projektmanagement-Tools. Es ist besonders für Nutzer interessant, die Wert auf Datenschutz und Datenkontrolle legen.

Ein wesentlicher Vorteil von Anytype ist der kostenlose Backup-Speicher von bis zu 1 GB für Dateien. Wenn dieser Speicherplatz erschöpft ist, funktionieren alle Funktionen weiterhin, allerdings werden neue Dateien dann nur noch lokal gespeichert. Die Zukunft wird zeigen, ob dies so bleibt, denn es gibt negative Beispiele von anderen Herstellern, z.B. Notion, Evernote, Dropbox oder Slack.

Anytype ist ein modularer No-Code-Builder, mit dem man alles visuell erstellen kann. Aktuell wird es für Projektmanagement, strategische Dokumente, tägliche Notizen, Aufgabenmanagement sowie Sammlungen von Büchern, Artikeln und anderen Interessen genutzt. Es eignet sich auch für persönliches CRM. Alle Inhalte sind Ende-zu-Ende-verschlüsselt, offline verfügbar, P2P-synchronisiert und extrem schnell. Alles, was du erstellst, gehört dir – du kontrollierst die Schlüssel, und Anytype hat keine Möglichkeit, Benutzer zu blockieren oder zentral zu registrieren. Der Code ist Open Source, sodass jeder die Funktionsweise überprüfen kann.

Anytype kann nicht im Browser genutzt werden. Es ist eine Desktop-Anwendung, die lokal auf deinem Computer installiert wird und eine lokal-first Architektur nutzt. Das bedeutet, dass alle Daten lokal gespeichert und verarbeitet werden. Es gibt keine Web-Version von Anytype, um die Privatsphäre und Sicherheit der Daten zu gewährleisten.

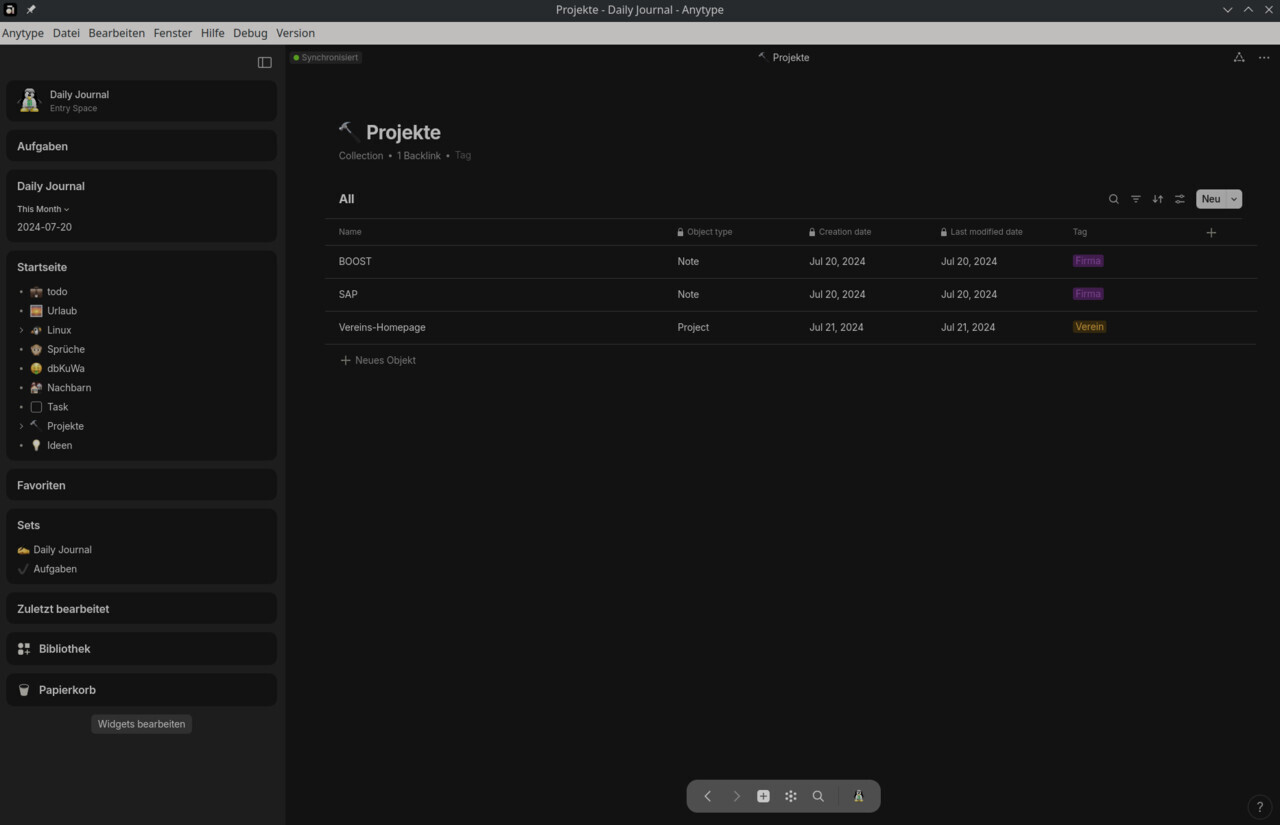

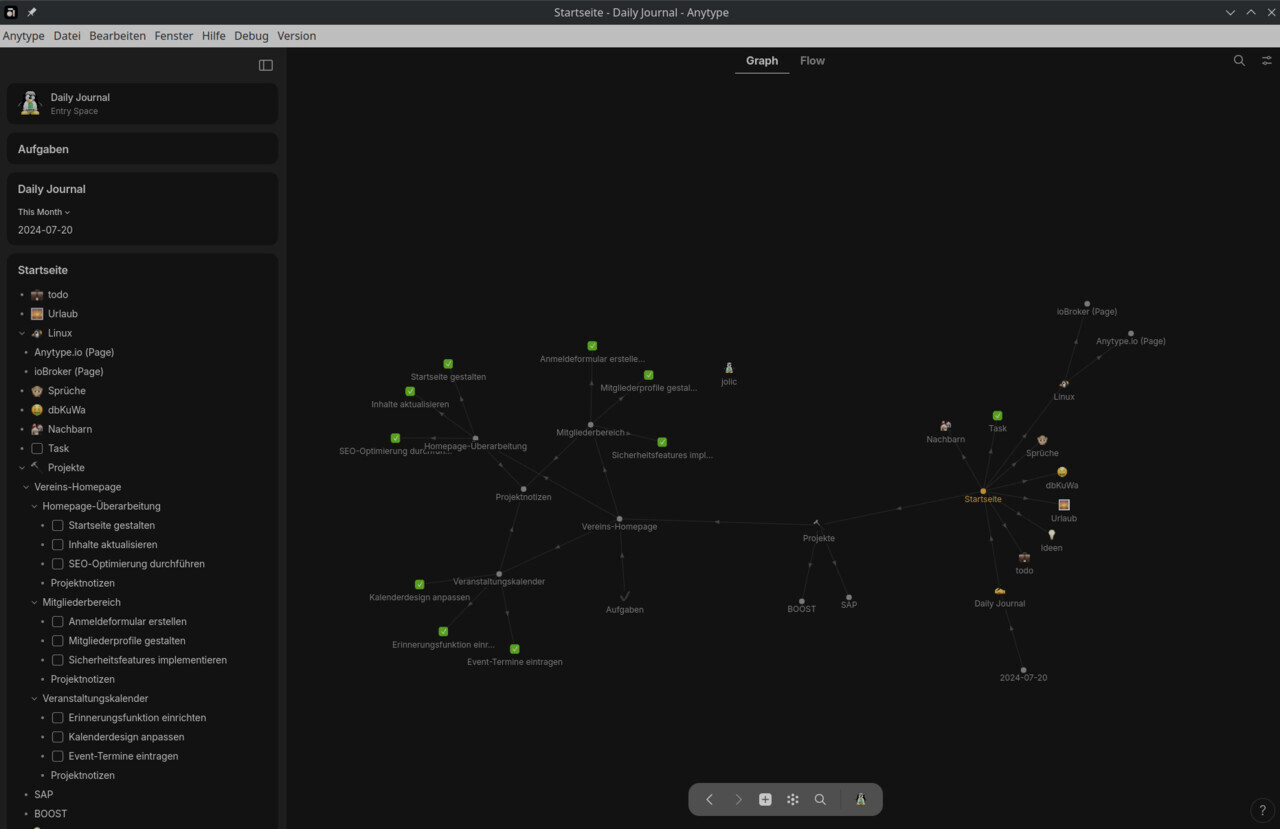

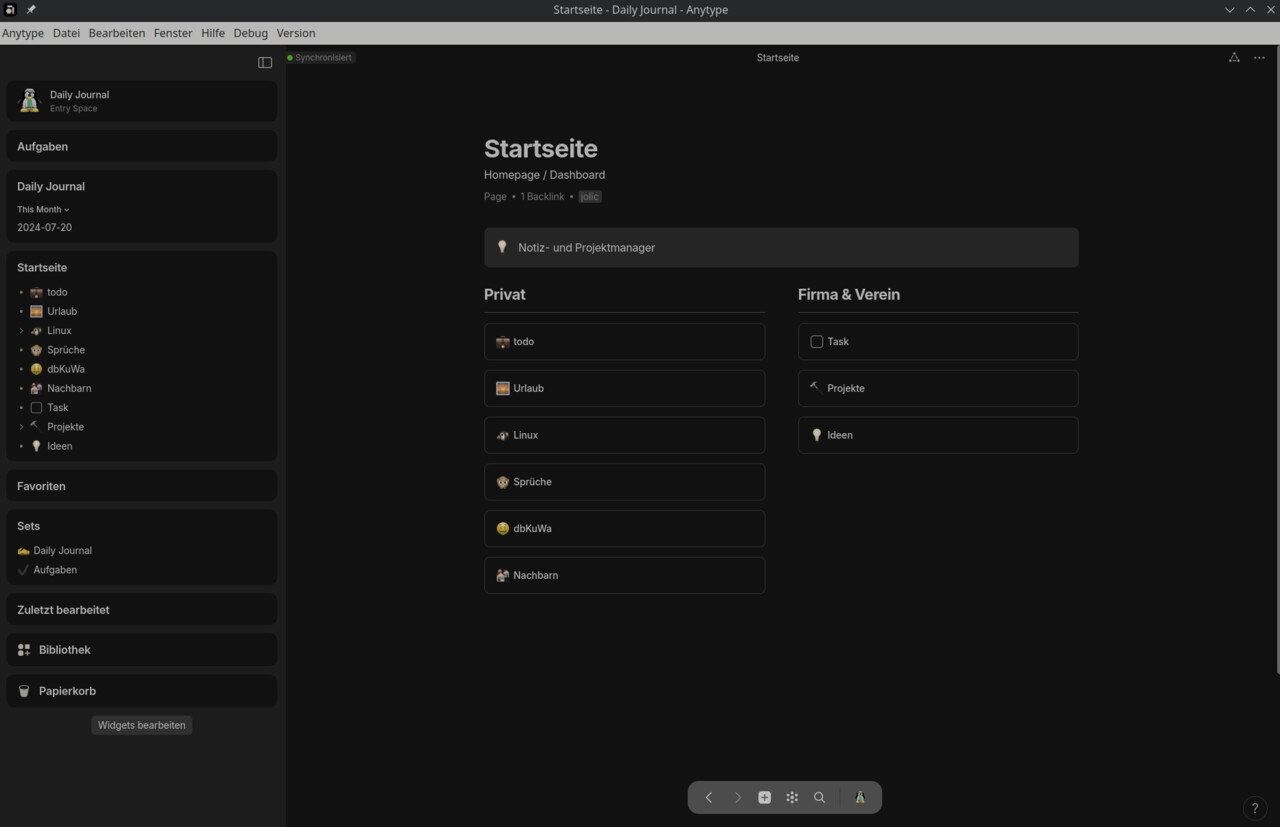

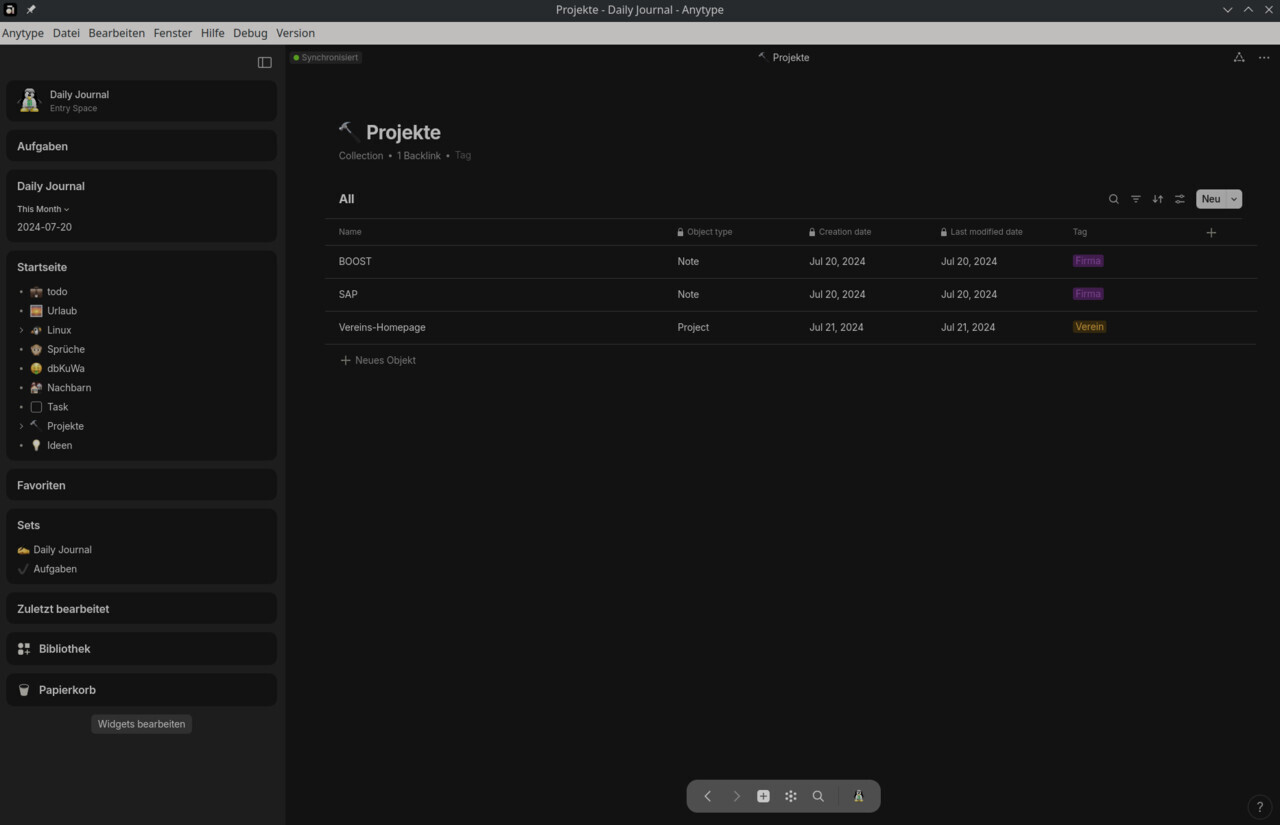

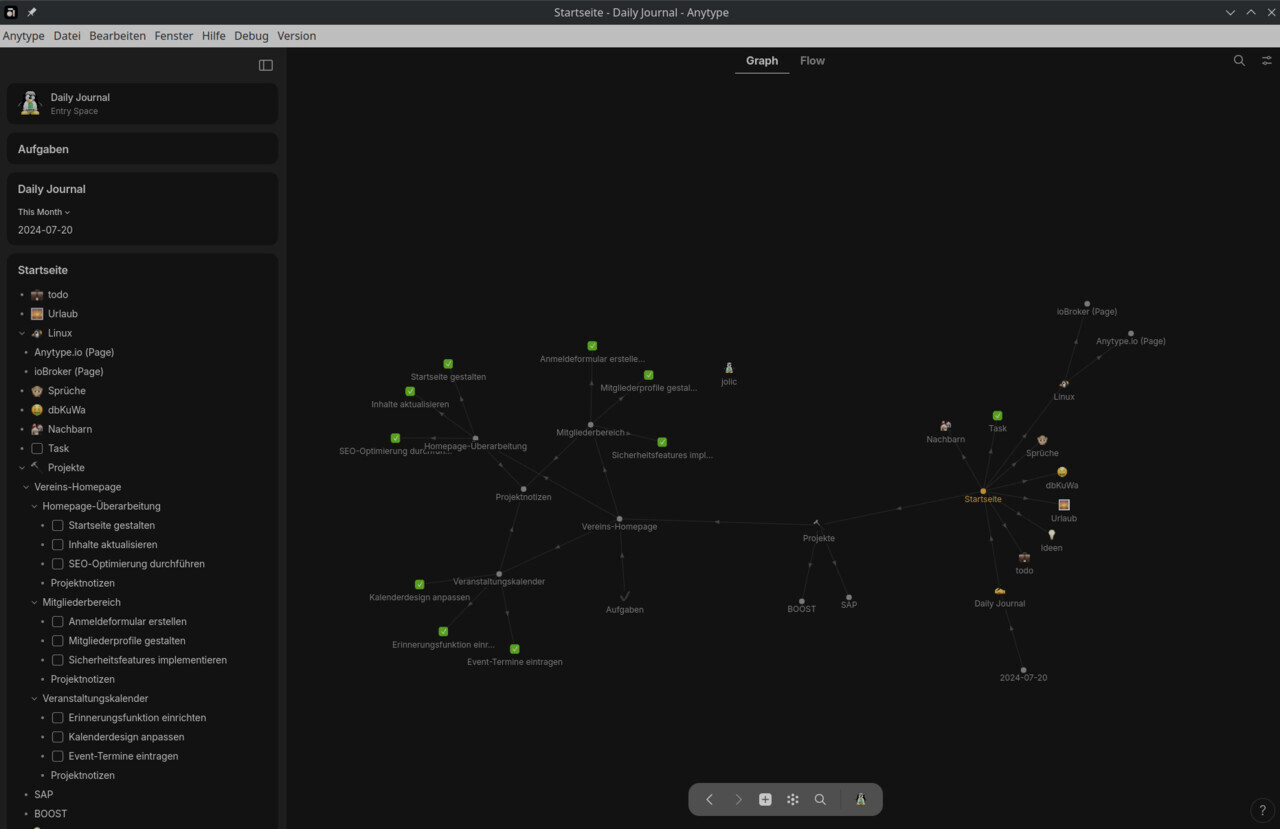

Die Screenshots zeigen nur einen kleinen Teil meiner ersten Versuche mit Anytype:

Anytype ist definitiv kein Tool für jedermann, doch wer sich darauf einlässt, dem sind nahezu keine Grenzen gesetzt. Eine gewisse Einarbeitungszeit ist erforderlich. Da eine vollständige Darstellung aller Funktionen an dieser Stelle den Rahmen sprengen würde, möchte ich im Folgenden nur die wichtigsten Basisfunktionen kurz vorstellen.

In Anytype ist alles ein Objekt und hat einen Typ. Um sinnvolle Unterscheidungen treffen zu können, müssen diese Objekte gruppiert werden. Sets helfen dabei, mehrere Objekte gleichzeitig zu visualisieren und zu verwalten.

Alle Elemente werden als Objekte betrachtet und haben einen bestimmten Typ. Um diese Objekte sinnvoll zu organisieren, ist es wichtig, sie in Gruppen zu ordnen, damit man leichter unterscheiden und darauf zugreifen kann.

Beispiel: Verwaltung einer Vereins-Homepage

1. Objekttypen

2. Gruppierung

3. Füge Aufgabenobjekte (Tasks Relation hinzufügen) als Unterprojekt hinzu

Füge in den jeweiligen Unterprojekt die Aufgabenobjekte per "Relation -> Tasks" hinzu.

Erstelle eine ,,Note" als Typ und benenne es entsprechend, z.B. ,,Projektnotizen". Füge den jeweiligen Unterprojekten diese Note nach Bedarf per "Relation -> new -> Linked Set" hinzu.

4. Nutze Filter und Ansichten innerhalb der Sets

Sets helfen dabei, mehrere Objekte gleichzeitig zu visualisieren und zu verwalten. Sets sind im Wesentlichen Sammlungen von Objekten, die nach bestimmten Kriterien gruppiert werden. Sie ermöglichen dir eine strukturierte und übersichtliche Darstellung von verwandten Objekten.

Anytype wird noch mächtiger, wenn man ihn im Team nutzt. Ob Einkaufsliste mit der Familie oder Vereinsprojekt mit Mitgliedern – der Dienst unterstützt vielfältige Anwendungen. Zudem kann er als Wissensdatenbank dienen, in der Informationen, Leselisten, Zeitpläne, Notizen und mehr gespeichert werden.

Um Anytype über das AUR auf Manjaro zu installieren, verwende den folgenden Befehl, nachdem du einen AUR-Helfer wie yay installiert hast:

Dieser Befehl installiert Anytype aus dem AUR und sorgt dafür, dass du bei neuen Versionen automatisch Updates erhältst. Beachte jedoch, dass AUR-Pakete von der Community gepflegt werden, was gelegentlich zu Verzögerungen oder kleinen Problemen führen kann.

Falls du zwischen den verfügbaren Paketen wählen musst, wähle ,,anytype-bin". Dies ist die Binärversion der stabilen Version von Anytype und wird empfohlen, wenn du eine getestete und stabile Version der Software möchtest.

Wähle dann ,,A", um alle Pakete neu zu erstellen. Die Option ,,Unterschiede anzeigen?" ist nur relevant, wenn du die Änderungen an den Build-Dateien überprüfen möchtest. Wenn du die Unterschiede nicht sehen möchtest, kannst du ,,N" wählen, um diesen Schritt zu überspringen.

Die Installation von Paketen aus dem AUR kann etwas länger dauern, da sie oft aus dem Quellcode kompiliert werden müssen. Die Dauer hängt von der Größe des Pakets und der Leistung deines Computers ab.

Nachdem das Paket erstellt wurde, kannst du es installieren, z.B.: "Pakete (1) anytype-bin-0.41.1-1"

Anytype gibt es auch als iOS-App und Android-App

Es kann sinnvoll sein, den Zugriff auf das lokale Netzwerk zu deaktivieren, wenn du der Meinung bist, dass die Anytype-App dies nicht benötigt. Der Zugriff auf das lokale Netzwerk wird normalerweise für Funktionen wie das Finden und Kommunizieren mit anderen Geräten im Netzwerk verwendet. Wenn du diese Funktionalität nicht benötigst, ist es sicher, den Zugriff zu deaktivieren.

Falls Anytype spezielle Funktionen hat, die Netzwerkzugriffe benötigen, wird die App dich informieren oder eine Fehlermeldung anzeigen, sodass du die Berechtigung wieder aktivieren kannst.

Quellen:

Links:

Hinweis: Ein Space von ANY Experience Gallery könnt ihr per ZIP-Datei importieren: Menü -> Datei -> "In Space importieren" (Any-Block).

Ein wesentlicher Vorteil von Anytype ist der kostenlose Backup-Speicher von bis zu 1 GB für Dateien. Wenn dieser Speicherplatz erschöpft ist, funktionieren alle Funktionen weiterhin, allerdings werden neue Dateien dann nur noch lokal gespeichert. Die Zukunft wird zeigen, ob dies so bleibt, denn es gibt negative Beispiele von anderen Herstellern, z.B. Notion, Evernote, Dropbox oder Slack.

Anytype ist ein modularer No-Code-Builder, mit dem man alles visuell erstellen kann. Aktuell wird es für Projektmanagement, strategische Dokumente, tägliche Notizen, Aufgabenmanagement sowie Sammlungen von Büchern, Artikeln und anderen Interessen genutzt. Es eignet sich auch für persönliches CRM. Alle Inhalte sind Ende-zu-Ende-verschlüsselt, offline verfügbar, P2P-synchronisiert und extrem schnell. Alles, was du erstellst, gehört dir – du kontrollierst die Schlüssel, und Anytype hat keine Möglichkeit, Benutzer zu blockieren oder zentral zu registrieren. Der Code ist Open Source, sodass jeder die Funktionsweise überprüfen kann.

Anytype kann nicht im Browser genutzt werden. Es ist eine Desktop-Anwendung, die lokal auf deinem Computer installiert wird und eine lokal-first Architektur nutzt. Das bedeutet, dass alle Daten lokal gespeichert und verarbeitet werden. Es gibt keine Web-Version von Anytype, um die Privatsphäre und Sicherheit der Daten zu gewährleisten.

Die Screenshots zeigen nur einen kleinen Teil meiner ersten Versuche mit Anytype:

Anytype ist definitiv kein Tool für jedermann, doch wer sich darauf einlässt, dem sind nahezu keine Grenzen gesetzt. Eine gewisse Einarbeitungszeit ist erforderlich. Da eine vollständige Darstellung aller Funktionen an dieser Stelle den Rahmen sprengen würde, möchte ich im Folgenden nur die wichtigsten Basisfunktionen kurz vorstellen.

In Anytype ist alles ein Objekt und hat einen Typ. Um sinnvolle Unterscheidungen treffen zu können, müssen diese Objekte gruppiert werden. Sets helfen dabei, mehrere Objekte gleichzeitig zu visualisieren und zu verwalten.

Alle Elemente werden als Objekte betrachtet und haben einen bestimmten Typ. Um diese Objekte sinnvoll zu organisieren, ist es wichtig, sie in Gruppen zu ordnen, damit man leichter unterscheiden und darauf zugreifen kann.

Beispiel: Verwaltung einer Vereins-Homepage

1. Objekttypen

- Project: Ein allgemeiner Typ für alle Projekte, die du verwalten möchtest.

- Task: Ein Typ für einzelne Aufgaben innerhalb eines Projekts.

- Note: Ein Typ für zusätzliche Informationen oder Gedanken zu einem Projekt oder einer Aufgabe.

2. Gruppierung

- Projekt-Gruppe (Typ Project): Erstelle eine Gruppe namens ,,Projekte", in der du alle deine Projekte ablegst, zum Beispiel: ,,Vereins-Homepage".

- Unterprojekte der Vereins-Homepage:

- Homepage-Überarbeitung: Dieses Unterprojekt umfasst alle Aufgaben (Task) und Notizen (Note), die mit der Überarbeitung der Vereins-Homepage verbunden sind.

- Mitgliederbereich: Dieses Unterprojekt umfasst alle Aufgaben (Task) und Notizen (Note), die mit dem Erstellen und Verwalten des Mitgliederbereichs verbunden sind.

- Veranstaltungskalender: Dieses Unterprojekt umfasst alle Aufgaben (Task) und Notizen (Note), die mit der Erstellung und Pflege des Veranstaltungskalenders verbunden sind.

Projekt Vereins-Homepage mit diesen Projekten per Relation verbinden: Neu -> Linked Projects -> Homepage-Überarbeitung, Mitgliederbereich und Veranstaltungskalender.

3. Füge Aufgabenobjekte (Tasks Relation hinzufügen) als Unterprojekt hinzu

- Unterprojekt ,,Homepage-Überarbeitung" fügst du Aufgabenobjekte wie ,,Startseite gestalten", ,,Inhalte aktualisieren" und ,,SEO-Optimierung durchführen" hinzu.

- Unterprojekt ,,Mitgliederbereich" fügst du Aufgabenobjekte wie ,,Anmeldeformular erstellen", ,,Mitgliederprofile gestalten" und ,,Sicherheitsfeatures implementieren" hinzu.

- Unterprojekt ,,Veranstaltungskalender" fügst du Aufgabenobjekte wie ,,Event-Termine eintragen", ,,Kalenderdesign anpassen" und ,,Erinnerungsfunktion einrichten" hinzu.

Füge in den jeweiligen Unterprojekt die Aufgabenobjekte per "Relation -> Tasks" hinzu.

Erstelle eine ,,Note" als Typ und benenne es entsprechend, z.B. ,,Projektnotizen". Füge den jeweiligen Unterprojekten diese Note nach Bedarf per "Relation -> new -> Linked Set" hinzu.

4. Nutze Filter und Ansichten innerhalb der Sets

- Stell dir vor, du verwaltest mehrere Projekte und möchtest die Aufgaben für jedes Projekt in einem Set zusammenfassen.

- Du kannst Filter anwenden, um nur bestimmte Aufgaben anzuzeigen, z.B. nur die Aufgaben, die für diese Woche geplant sind.

- Du kannst unterschiedliche Ansichten wählen, um die Aufgaben als Liste, Kanban-Board oder in einer anderen für dich hilfreichen Darstellung zu sehen.

Sets helfen dabei, mehrere Objekte gleichzeitig zu visualisieren und zu verwalten. Sets sind im Wesentlichen Sammlungen von Objekten, die nach bestimmten Kriterien gruppiert werden. Sie ermöglichen dir eine strukturierte und übersichtliche Darstellung von verwandten Objekten.

Anytype wird noch mächtiger, wenn man ihn im Team nutzt. Ob Einkaufsliste mit der Familie oder Vereinsprojekt mit Mitgliedern – der Dienst unterstützt vielfältige Anwendungen. Zudem kann er als Wissensdatenbank dienen, in der Informationen, Leselisten, Zeitpläne, Notizen und mehr gespeichert werden.

Um Anytype über das AUR auf Manjaro zu installieren, verwende den folgenden Befehl, nachdem du einen AUR-Helfer wie yay installiert hast:

Code Auswählen

yay -S anytype(https://aur.archlinux.org/packages/anytype-bin)Dieser Befehl installiert Anytype aus dem AUR und sorgt dafür, dass du bei neuen Versionen automatisch Updates erhältst. Beachte jedoch, dass AUR-Pakete von der Community gepflegt werden, was gelegentlich zu Verzögerungen oder kleinen Problemen führen kann.

Falls du zwischen den verfügbaren Paketen wählen musst, wähle ,,anytype-bin". Dies ist die Binärversion der stabilen Version von Anytype und wird empfohlen, wenn du eine getestete und stabile Version der Software möchtest.

Wähle dann ,,A", um alle Pakete neu zu erstellen. Die Option ,,Unterschiede anzeigen?" ist nur relevant, wenn du die Änderungen an den Build-Dateien überprüfen möchtest. Wenn du die Unterschiede nicht sehen möchtest, kannst du ,,N" wählen, um diesen Schritt zu überspringen.

Die Installation von Paketen aus dem AUR kann etwas länger dauern, da sie oft aus dem Quellcode kompiliert werden müssen. Die Dauer hängt von der Größe des Pakets und der Leistung deines Computers ab.

Nachdem das Paket erstellt wurde, kannst du es installieren, z.B.: "Pakete (1) anytype-bin-0.41.1-1"

Anytype gibt es auch als iOS-App und Android-App

Es kann sinnvoll sein, den Zugriff auf das lokale Netzwerk zu deaktivieren, wenn du der Meinung bist, dass die Anytype-App dies nicht benötigt. Der Zugriff auf das lokale Netzwerk wird normalerweise für Funktionen wie das Finden und Kommunizieren mit anderen Geräten im Netzwerk verwendet. Wenn du diese Funktionalität nicht benötigst, ist es sicher, den Zugriff zu deaktivieren.

Falls Anytype spezielle Funktionen hat, die Netzwerkzugriffe benötigen, wird die App dich informieren oder eine Fehlermeldung anzeigen, sodass du die Berechtigung wieder aktivieren kannst.

Quellen:

Links:

Hinweis: Ein Space von ANY Experience Gallery könnt ihr per ZIP-Datei importieren: Menü -> Datei -> "In Space importieren" (Any-Block).

#9

LINUX / 2024-07-14 Großes Update! Warn...

Letzter Beitrag von Jo - 2024-07-16 | 19:29:412024-07-14 Großes Update und Qt 6.7.2 (externer Link: forum.manjaro.org)

Beim Update per `pamac upgrade` oder `sudo pacman -Syyuu` erscheinen die folgenden Meldungen:

Die Abhängigkeits-Zyklus-Warnungen kannst du ignorieren, diese werden beim Update des Systems in der richtigen Reihenfolge abgearbeitet. Nur die erste Warnung erscheint nach einem Neustart des PCs und einem weiteren Update-Aufruf immer wieder.

Die Warnung besagt, dass die lokal installierte Version von `nano-syntax-highlighting` neuer ist als die Version im extra-Repository. Das bedeutet, dass die Version auf dem System (2020.10.10+10+g1aa64a8-2) eine neuere Build-Version ist als die, die im extra-Repository verfügbar ist (2020.10.10-2).

Mögliche Gründe, warum diese Warnung erscheint:

Eine effektive Lösung ist es, zuerst die neueren Versionen zu deinstallieren und dann die Versionen aus dem offiziellen Repository neu zu installieren. Dies stellt sicher, dass du wieder die offiziell unterstützten Versionen der Pakete verwendest und behebt die Versionskonflikte:

Dann wie immer obligatorisch:

Beim Update per `pamac upgrade` oder `sudo pacman -Syyuu` erscheinen die folgenden Meldungen:

ZitatWarnung: nano-syntax-highlighting: Lokale Version (2020.10.10+10+g1aa64a8-2) ist neuer als extra (2020.10.10-2)

Warnung: Abhängigkeits-Zyklus entdeckt:

Warnung: harfbuzz wird vor seiner Abhängigkeit freetype2 installiert werden

Warnung: Abhängigkeits-Zyklus entdeckt:

Warnung: qt6-multimedia-ffmpeg wird vor seiner Abhängigkeit qt6-multimedia installiert werden

Die Abhängigkeits-Zyklus-Warnungen kannst du ignorieren, diese werden beim Update des Systems in der richtigen Reihenfolge abgearbeitet. Nur die erste Warnung erscheint nach einem Neustart des PCs und einem weiteren Update-Aufruf immer wieder.

Die Warnung besagt, dass die lokal installierte Version von `nano-syntax-highlighting` neuer ist als die Version im extra-Repository. Das bedeutet, dass die Version auf dem System (2020.10.10+10+g1aa64a8-2) eine neuere Build-Version ist als die, die im extra-Repository verfügbar ist (2020.10.10-2).

Mögliche Gründe, warum diese Warnung erscheint:

- Manuelles Update: Es könnte sein, dass du `nano-syntax-highlighting` manuell von einer anderen Quelle (wie GitHub) installiert hast, die eine neuere Version als das offizielle Repository bereitgestellt hat.

- AUR: Wenn du das Arch User Repository (AUR) verwendest, könnte es sein, dass du eine AUR-Version von `nano-syntax-highlighting` installiert hast, die neuer ist als die im offiziellen Repository verfügbare Version (war wahrscheinlich der Grund bei mir).

- Partielle Upgrades: Wenn du das System nicht vollständig aktualisiert hast und nur bestimmte Pakete, könnte dies zu Versionsinkonsistenzen führen.

Eine effektive Lösung ist es, zuerst die neueren Versionen zu deinstallieren und dann die Versionen aus dem offiziellen Repository neu zu installieren. Dies stellt sicher, dass du wieder die offiziell unterstützten Versionen der Pakete verwendest und behebt die Versionskonflikte:

Code Auswählen

sudo pacman -Rns nano-syntax-highlighting nano

sudo pacman -S nano nano-syntax-highlighting

Dann wie immer obligatorisch:

Code Auswählen

sudo pacman -Rsn $(pacman -Qdtq)

pamac upgradeund wenn du AUR nutzt:Code Auswählen

yay -Syyuu

#10

LINUX / KDE Connect

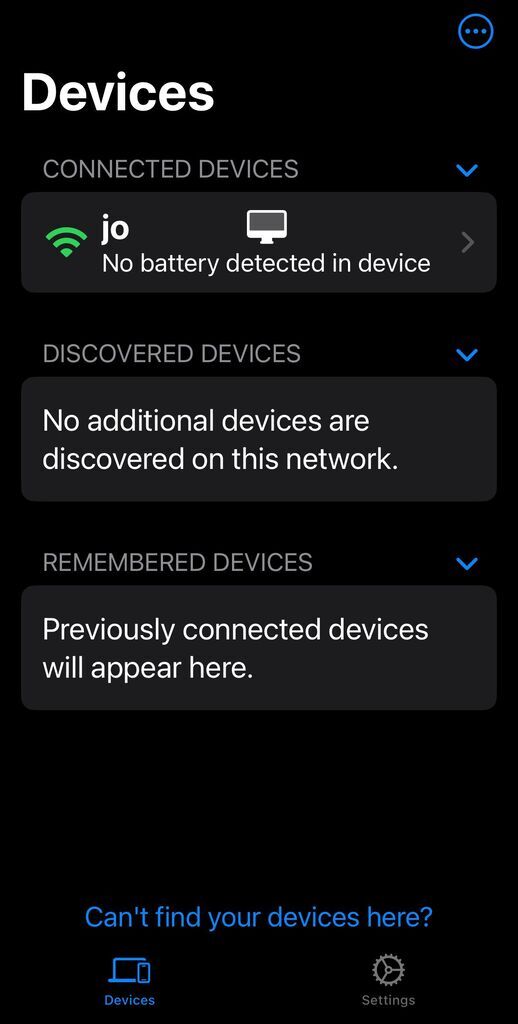

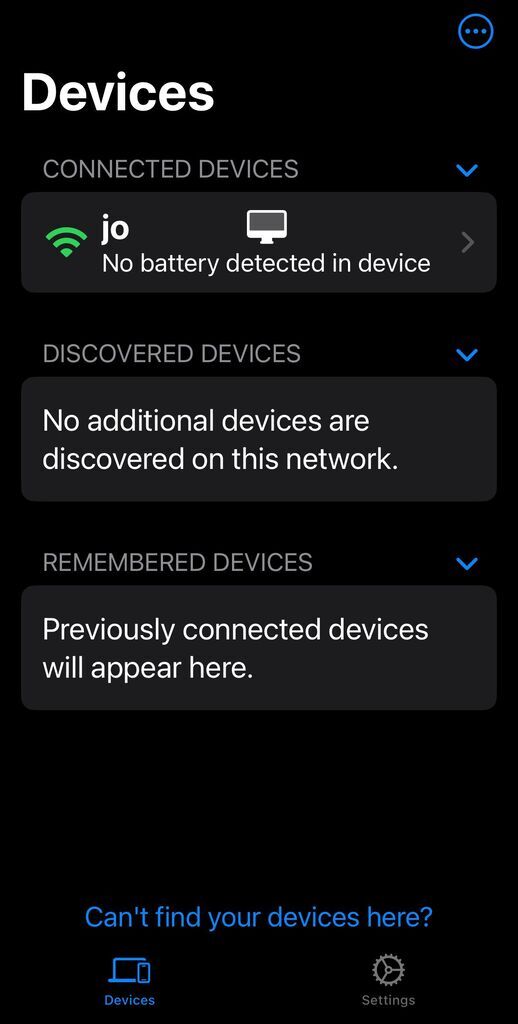

Letzter Beitrag von Jo - 2024-07-07 | 12:50:12KDE Connect ist eine kostenlose Open-Source-Software, die entwickelt wurde, um die Integration zwischen deinem Computer und Smartphones zu verbessern. Derzeit ist die Funktionalität von KDE Connect auf iPhones im Vergleich zu Android-Geräten eingeschränkt. Das liegt an den restriktiveren Richtlinien und API-Beschränkungen von iOS. Im Moment unterstützt KDE Connect auf iOS nur das versenden von Fotos und Videos. Dies ist nützlich, wenn du schnell Bilder vom Smartphone auf den PC übertragen möchtest, ohne Kabel zu verwenden.

Der KDE Connect Daemon ist ein Hintergrunddienst, der für die Kommunikation zwischen deinem Computer und deinem mobilen Gerät verantwortlich ist. Vergewissere dich, dass sowohl dein Linux-Computer als auch dein Smartphone mit demselben Netzwerk verbunden sind, z.B. PC per LAN und das iPhone per WLAN.

Installiere KDE Connect auf deinem Smartphone per App Store und unter Linux Manjaro z.B. per Konsole:

Kurzanleitung

Smartphone mit KDE Connect auf Manjaro verbinden. Sicherstellen, dass Smartphone und PC im selben Netzwerk sind und, falls du eine Firewall nutzt, diese die Verbindungen für KDE Connect nicht blockiert. Starte die KDE Connect Anwendung auf deinem PC. In der KDE Connect App siehst du eine Liste von verfügbaren Geräten. Dein Computer sollte in der Liste erscheinen. Wähle deinen Computer aus und tippe auf "Verbinden". Eine Benachrichtigung oder ein Popup sollte auf deinem PC erscheinen, dass dein Smartphone eine Verbindungsanfrage sendet. Bestätige die Verbindungsanfrage.

In der KDE Connect App, wähle deinen PC unter "Connected Devices" aus und tippe auf "Send Photos and Videos". Wähle die Bilder oder Videos aus, die du senden möchtest. Bestätige die Auswahl, um die Dateien zu übertragen. Jetzt sollten die ausgewählten Dateien auf deinem PC im Ordner "Downloads" ankommen.

Wenn dein PC in der Smartphone-App unter "Connected Devices" nicht erscheint, versuche, "Refresh Discovery" auszuführen.

Konsolenbefehle und evtl. Fehlersuche

KDE Connect mit folgendem Befehl starten:

Stelle sicher, dass der KDE Connect Daemon (kdeconnectd) im Hintergrund läuft. Du kannst dies mit dem folgenden Befehl überprüfen:

Wenn du die grafische Benutzeroberfläche (GUI) von KDE Connect starten möchtest, kannst du den folgenden Befehl verwenden:

Um eine Liste der verfügbaren Geräte im Netzwerk anzuzeigen, kannst du den folgenden Befehl ausführen:

Um ein Gerät zu koppeln, verwende den Befehl:

Um eine Liste der gekoppelten Geräte anzuzeigen, kannst du den folgenden Befehl verwenden:

Um ein Gerät zu trennen, kannst du den folgenden Befehl verwenden:

Um Protokolle von KDE Connect anzuzeigen, die dir helfen können, Fehler zu identifizieren, kannst du den folgenden Befehl verwenden:

Vergewissere dich, dass dein Netzwerk keine Einstellungen hat, die die Kommunikation blockieren könnten (wie z.B. Firewall-Einstellungen). Achte darauf, dass die Ports 1714 bis 1764 geöffnet sind. Du kannst überprüfen, ob ufw (Uncomplicated Firewall) oder firewalld installiert und aktiv ist:

Stelle sicher, dass die Geräte korrekte IP-Adressen im selben Subnetz haben. Du kannst die IP-Adresse deines Linux-Computers mit folgendem Befehl herausfinden:

Laufende Prozesse, die mit "kdeconnect" in Verbindung stehen, suchen:

Der Befehl nmap wird verwendet, um die Ports 1714 bis 1764 auf dem Gerät mit der IP-Adresse 192.168.1.42 (passe die IP-Adresse deines Smartphones an) zu scannen. Dies hilft zu überprüfen, ob die Ports, die von KDE Connect verwendet werden, offen sind und erreichbar sind. Installieren:

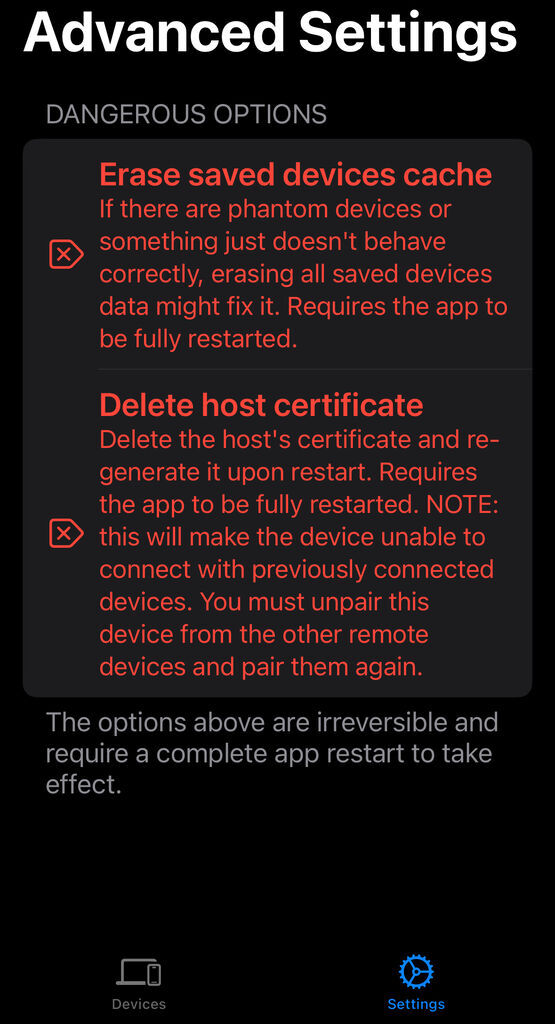

KDE Connect -> keine Verbindung zum Smartphone (Disconnecting due to fatal SSL Error)

Ich hatte über einen längeren Zeitraum keine Probleme mit KDE Connect, doch plötzlich konnte ich keine Verbindung mehr zu meinem Smartphone herstellen. Selbst eine Neuinstallation auf dem Smartphone und PC hat nicht geholfen. In der Konsole erschien die Meldung:

Das Zertifikat habe ich mit folgendem Befehl überprüft:

Daher habe ich mein System natürlich wie folgt geupdatet und KDE Connect vollständig zurückgesetzt, um eventuelle Warnungen bezüglich der Gültigkeit des Zertifikats zu verhindern (KDE Connect generiert diese dann neu).

Jedoch erschien nach einem "Refresh Discovery" auf dem iPhone in der Konsole wieder die Meldung "Die Gültigkeit des Zertifikats ist abgelaufen". Nur gelegentlich funktionierte das neue Pairing, bis ich die Konsole mit STRG + C oder die iPhone-App geschlossen hatte.

Eventuelle Warnungen bezüglich Battery, ModemManager und Pulseaudio könnt ihr ignorieren. Damit hatte ich nie ein Problem. Ich hatte mich stundenlang damit herumgeschlagen und endlich die Lösung hier gefunden: github.com/NixOS/nixpkgs/issues/240606.

Das Linux-Zertifikat gilt 10 Jahre (siehe Abfrage oben), aber anscheinend nicht auf dem iPhone. Angeblich soll es dort nur 2 Jahre gültig sein, obwohl mein iPhone noch kein Jahr alt war. Möglicherweise wurde es durch einen Umzug beeinflusst?

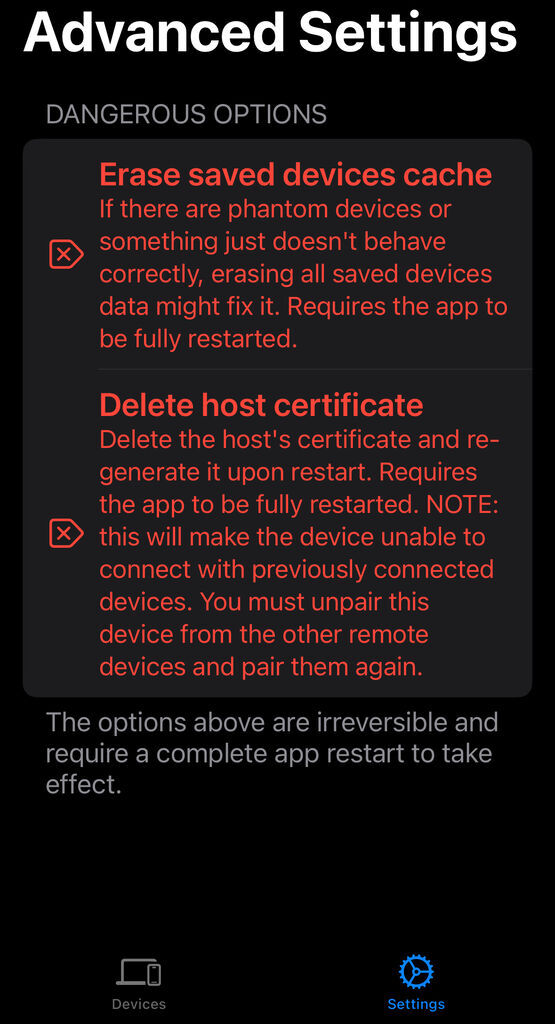

Wenn ihr auf solch ein Problem stoßt, vergeudet eure Zeit nicht und setzt die Smartphone-App unter "Settings" -> "Advanced Settings" per "Erase saved devices cache" und "Delete host certificate" zurück. Startet die App neu und paart eure Geräte erneut.

Der KDE Connect Daemon ist ein Hintergrunddienst, der für die Kommunikation zwischen deinem Computer und deinem mobilen Gerät verantwortlich ist. Vergewissere dich, dass sowohl dein Linux-Computer als auch dein Smartphone mit demselben Netzwerk verbunden sind, z.B. PC per LAN und das iPhone per WLAN.

Installiere KDE Connect auf deinem Smartphone per App Store und unter Linux Manjaro z.B. per Konsole:

Code Auswählen

sudo pacman -S kdeconnectKurzanleitung

Smartphone mit KDE Connect auf Manjaro verbinden. Sicherstellen, dass Smartphone und PC im selben Netzwerk sind und, falls du eine Firewall nutzt, diese die Verbindungen für KDE Connect nicht blockiert. Starte die KDE Connect Anwendung auf deinem PC. In der KDE Connect App siehst du eine Liste von verfügbaren Geräten. Dein Computer sollte in der Liste erscheinen. Wähle deinen Computer aus und tippe auf "Verbinden". Eine Benachrichtigung oder ein Popup sollte auf deinem PC erscheinen, dass dein Smartphone eine Verbindungsanfrage sendet. Bestätige die Verbindungsanfrage.

In der KDE Connect App, wähle deinen PC unter "Connected Devices" aus und tippe auf "Send Photos and Videos". Wähle die Bilder oder Videos aus, die du senden möchtest. Bestätige die Auswahl, um die Dateien zu übertragen. Jetzt sollten die ausgewählten Dateien auf deinem PC im Ordner "Downloads" ankommen.

Wenn dein PC in der Smartphone-App unter "Connected Devices" nicht erscheint, versuche, "Refresh Discovery" auszuführen.

Konsolenbefehle und evtl. Fehlersuche

KDE Connect mit folgendem Befehl starten:

Code Auswählen

kdeconnectdStelle sicher, dass der KDE Connect Daemon (kdeconnectd) im Hintergrund läuft. Du kannst dies mit dem folgenden Befehl überprüfen:

Code Auswählen

ps -e | grep kdeconnectdWenn du die grafische Benutzeroberfläche (GUI) von KDE Connect starten möchtest, kannst du den folgenden Befehl verwenden:

Code Auswählen

kdeconnect-appUm eine Liste der verfügbaren Geräte im Netzwerk anzuzeigen, kannst du den folgenden Befehl ausführen:

Code Auswählen

kdeconnect-cli -lUm ein Gerät zu koppeln, verwende den Befehl:

Code Auswählen

kdeconnect-cli --pair --device DEVICE_IDErsetze DEVICE_ID durch die ID des Geräts, das du koppeln möchtest (die ID bekommst du aus dem vorherigen Befehl kdeconnect-cli -l).Um eine Liste der gekoppelten Geräte anzuzeigen, kannst du den folgenden Befehl verwenden:

Code Auswählen

kdeconnect-cli -aUm ein Gerät zu trennen, kannst du den folgenden Befehl verwenden:

Code Auswählen

kdeconnect-cli --unpair --device DEVICE_IDUm Protokolle von KDE Connect anzuzeigen, die dir helfen können, Fehler zu identifizieren, kannst du den folgenden Befehl verwenden:

Code Auswählen

journalctl -u kdeconnectdVergewissere dich, dass dein Netzwerk keine Einstellungen hat, die die Kommunikation blockieren könnten (wie z.B. Firewall-Einstellungen). Achte darauf, dass die Ports 1714 bis 1764 geöffnet sind. Du kannst überprüfen, ob ufw (Uncomplicated Firewall) oder firewalld installiert und aktiv ist:

Code Auswählen

sudo ufw statusFür firewalld:Code Auswählen

sudo systemctl status firewalldStelle sicher, dass die Geräte korrekte IP-Adressen im selben Subnetz haben. Du kannst die IP-Adresse deines Linux-Computers mit folgendem Befehl herausfinden:

Code Auswählen

ip addr showLaufende Prozesse, die mit "kdeconnect" in Verbindung stehen, suchen:

Code Auswählen

ps -ef | grep kdeconnectPrüfen, ob dein Smartphone per Ping erreichbar ist (passe die IP-Adresse an):Code Auswählen

ping 192.168.1.42Der Befehl nmap wird verwendet, um die Ports 1714 bis 1764 auf dem Gerät mit der IP-Adresse 192.168.1.42 (passe die IP-Adresse deines Smartphones an) zu scannen. Dies hilft zu überprüfen, ob die Ports, die von KDE Connect verwendet werden, offen sind und erreichbar sind. Installieren:

Code Auswählen

sudo pacman -S --needed nmapAusführen:Code Auswählen

sudo nmap -p 1714-1764 192.168.1.42Ein positive Ergebnis sollte dann in etwa so aussehen:ZitatStarting Nmap 7.95 ( https://nmap.org ) at 2024-07-07 12:42 CEST

Nmap scan report for USER.fritz.box (192.168.1.42)

Host is up (0.0057s latency).

Not shown: 50 closed tcp ports (reset)

PORT STATE SERVICE

1716/tcp open xmsg

MAC Address: xx:xx:xx:xx:xx:xx (Apple)

Nmap done: 1 IP address (1 host up) scanned in 0.37 seconds

KDE Connect -> keine Verbindung zum Smartphone (Disconnecting due to fatal SSL Error)

Ich hatte über einen längeren Zeitraum keine Probleme mit KDE Connect, doch plötzlich konnte ich keine Verbindung mehr zu meinem Smartphone herstellen. Selbst eine Neuinstallation auf dem Smartphone und PC hat nicht geholfen. In der Konsole erschien die Meldung:

Code Auswählen

kdeconnect.core: Disconnecting due to fatal SSL Error: "Die Gültigkeit des Zertifikats ist abgelaufen"Das Zertifikat habe ich mit folgendem Befehl überprüft:

Code Auswählen

openssl x509 -in ~/.config/kdeconnect/certificate.pem -text -nooutJedoch hatte das Zertifikat ein gültiges ,,Not Before"-Datum (16. Juli 2023) und ein ,,Not After"-Datum (5. April 2034), ist also gültig und nicht abgelaufen.Daher habe ich mein System natürlich wie folgt geupdatet und KDE Connect vollständig zurückgesetzt, um eventuelle Warnungen bezüglich der Gültigkeit des Zertifikats zu verhindern (KDE Connect generiert diese dann neu).

Code Auswählen

sudo pacman -Syyuu

killall kdeconnectd

rm -rf ~/.config/kdeconnect

rm -rf ~/.cache/kdeconnect

rm -rf ~/.local/share/kdeconnect.appDann den KDE Connect Daemon neu gestartet:Code Auswählen

kdeconnectd &Jedoch erschien nach einem "Refresh Discovery" auf dem iPhone in der Konsole wieder die Meldung "Die Gültigkeit des Zertifikats ist abgelaufen". Nur gelegentlich funktionierte das neue Pairing, bis ich die Konsole mit STRG + C oder die iPhone-App geschlossen hatte.

Eventuelle Warnungen bezüglich Battery, ModemManager und Pulseaudio könnt ihr ignorieren. Damit hatte ich nie ein Problem. Ich hatte mich stundenlang damit herumgeschlagen und endlich die Lösung hier gefunden: github.com/NixOS/nixpkgs/issues/240606.

Das Linux-Zertifikat gilt 10 Jahre (siehe Abfrage oben), aber anscheinend nicht auf dem iPhone. Angeblich soll es dort nur 2 Jahre gültig sein, obwohl mein iPhone noch kein Jahr alt war. Möglicherweise wurde es durch einen Umzug beeinflusst?

Wenn ihr auf solch ein Problem stoßt, vergeudet eure Zeit nicht und setzt die Smartphone-App unter "Settings" -> "Advanced Settings" per "Erase saved devices cache" und "Delete host certificate" zurück. Startet die App neu und paart eure Geräte erneut.